Список найпопулярніших шахрайств Deepfake.

Почнемо з цього «особливого» звернення «POTUS» Джо Байдена:

Це трохи нагадує те, як може виглядати глибоке фейкове (голосове) шахрайство. Насправді це було безкоштовно Інструмент клонування AI-голосуі я витратив трохи більше п’яти хвилин на написання (за допомогою ChatGPT) і вставлення тексту, щоб перетворити його на промову (Байдена).

Однак глибоке фальшиве шахрайство більш витончене, ніж це. Все, що вам потрібно, це кілька високоякісних фотографій, відео чи аудіо суб’єкта (жертви) і потужна графічна карта, щоб почати.

Але ми тут не для того, щоб обговорювати, як створювати глибокі фейкові відео. Це також не стосується виявлення дипфейків.

Натомість у цій статті коротко розповідається про глибокі фейки та згадуються кілька таких шахрайств, яких варто остерігатися.

Що таке Deepfakes?

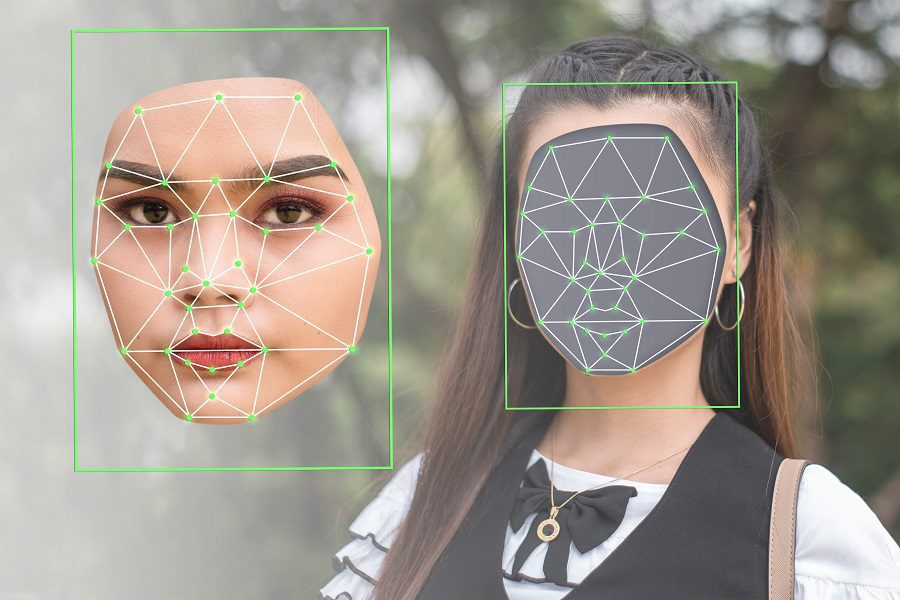

Deepfake поєднує два терміни: Deep (від глибокого навчання, яке використовується для їх створення) і fake (вказує на природу результату).

Коротше кажучи, алгоритми глибокого навчання розгортаються для створення переконливих зображень, аудіо- чи відеовмісту з оригінального вмісту високої роздільної здатності.

Це класичний приклад глибокого фейку, який певною мірою виглядає ефективним. Але все одно їй п’ять років, і ця технологія розвивається швидкими темпами.

І це не завжди робиться для розваги чи демонстрації чиїхось здібностей ШІ. Один із таких серйозних випадків – коли «Mr. Володимира Зеленського» його сили просять здатися в триваючих російсько-українська війна.

На жаль, це не один такий випадок. Відповідно до Звіт Regula Forensics 202337% глобальних організацій стикалися з голосовим шахрайством Deepfake, 29% — з шахрайством із синтетичним відео, а 46% — зі спробами викрадення особистих даних.

Отже, це не лише розвага, а дипфейк широко використовується для поширення дезінформації та зловживає масою інших способів, які можуть бути небезпечними та тривожними для жертв.

Крім того, боротися з контентом deepfake нелегко. Вони є побічними ефектами значного прогресу в технології ШІ та того факту, що такі інструменти зараз широко доступні для загального використання.

Тому найбільшим і найпоширенішим захистом, який ми маємо, є усвідомлення.

Отже, давайте попрацюємо над цими аспектами та розглянемо типи шахрайства з глибокими фейками.

Типи шахрайства Deepfake

Залежно від змісту та мети шахрайство deepfake можна розділити на кілька форм, наприклад:

- Видання за відео

- Фейкові інтерв’ю

- Фейкові новини

- Голосове шахрайство

- Медолов

- Підтримка клієнтів

- Відгуки

Подальші розділи детально розповідають про них та деякі їх модифікації.

Видання за відео

Це добре відоме шахрайство deepfake, коли ми бачимо вигадане відео, яке загалом нагадує мішень високого рівня. Типовою жертвою може бути президент країни (наприклад, діпфейк Обами), популярна голлівудська зірка або генеральний директор відомої компанії.

Що робить їх легкою мішенню, так це публічний доступ до їхніх фотографій, промов тощо, оскільки інструменти для створення глибоких фейкових відео добре працюють із різними вхідними даними, що відображають різні діапазони емоцій, кути обличчя, умови освітлення, фон тощо.

Наміром такого видавання себе за іншу особу може бути звичайна розвага, спроба шантажу, політична мотивація, наклеп чи щось інше.

У рідкісних випадках можна побачити глибокі фейки, на яких члени сім’ї просять гроші або доступ до цінних речей.

Фальшиві інтерв’ю

Зайве говорити, що фейкові співбесіди з використанням технології deepfake націлені на повністю віддалені посади, які працюють з дому. Ці шахрайські програми намагаються відтворювати глибокі підробки відео в режимі реального часу через програми для конференцій, такі як Zoom.

Крім того, що цільова компанія може отримати кандидата, який не відповідає вимогам, цільова компанія ризикує розкрити свої активи шахраю. І виходячи з угод компанії, це не тільки може завдати шкоди їхнім власним ресурсам, але й може поставити під загрозу інтереси їхньої країни.

Простішою метою глибоких фейкових інтерв’ю може бути отримання грошей у коштовній валюті.

З іншого боку, шахраї можуть стягувати з невинних кандидатів плату за співбесіду, щоб поставити їх перед «галузевими магнатами» за одну велику спробу отримати роботу їх мрії.

Фейкові новини

Найпоширенішим шахрайством із deepfake є фейкові новини. Такі онлайн-кампанії з дезінформації створюють ризики, які можуть виявитися фатальними в складних ситуаціях, таких як заворушення чи війни.

Мало того, це може наклепити публічних діячів, коли їх копія deepfake робить коментарі, яких вони ніколи не робили насправді.

Пропаганді допомагають соціальні медіа та потокові платформи, такі як YouTube, які допомагають таким фейковим новинам поширюватися як лісова пожежа. Зрештою, це створює атмосферу, в якій звичайні користувачі плутаються щодо автентичності всього, що вони бачать.

Голосове шахрайство

Подібно до відео та зображень deepfake, синтетичний голос є ще одним доповненням до списку таких технологічних хитрощів.

В одному з таких випадків Дженніфер ДеСтефано, жителька Арізони, почула, як її 15-річна дочка ридала по телефону, а чоловічий голос вимагав 1 мільйон доларів за звільнення. Мати була переконана, що її дитині загрожує небезпека. Перш ніж вона встигла подумати про оплату, їхня подруга зателефонувала чоловікові, підтвердивши, що її дочка в безпеці.

Пізніше пані ДеСтефано розповіла про випробування, що вона повністю повірила голосу, не лише за його звуком, але й за загальним тоном, який точно відповідав тому, як зазвичай говорить її донька.

Це клонування голосу, яке виконується за допомогою необроблених зразків аудіо з джерела.

Медові пастки

Відповідно до традиційного визначення медової пастки, це місце, де суб’єкта вмовляють у стосунки, щоб вимагати конфіденційну інформацію. Медові пастки зазвичай націлені на високопоставлені організації, як-от співробітники збройних сил, високопосадовці уряду, обслуговуючі політики тощо.

Завдяки технології deepfake ці honeytrapes здебільшого онлайн, і їх може виконувати будь-хто в масштабі. Це означає, що жертва може отримувати запити на стосунки від привабливих партнерів через соціальні мережі, які швидко стають інтимними з кінцевою метою фінансового чи інформаційного вимагання.

Такі глибокі фейкові шахрайства, як правило, є бажаними операціями, які проходять свій час, перш ніж закласти останню пастку.

Підтримка клієнтів

Шахрайство зі службою технічної підтримки дуже поширене. Можливо, ви чули про шахрайство, коли якийсь хлопець із “Microsoft” просить вас заплатити за вирішення “серйозних” проблем вашого комп’ютера.

До deepfake їхні акценти чи незвичні моделі мовлення видавали зловмисні спроби. Але тепер ці шахраї мають надздібності штучного інтелекту, які можуть легко обдурити невинних користувачів, змусивши їх подумати, що вони насправді розмовляють із законним представником компанії.

Відгуки

Багато хто з нас читає відгуки покупців перед покупкою будь-якого товару. Подібним чином перевірка відеовідгуків є ще однією звичкою для покупок, яка виявилася корисною досі.

Цей тип глибокого фейкового шахрайства змусить кількох людей ручатися за поганий продукт, впливати на рішення про покупку та витрачати гроші та час клієнтів.

Є ще багато!

Що ви бачите в Інтернеті, крім тексту?

Я б сказав відео, зображення та аудіо. Усім цим можна маніпулювати за допомогою цієї технології штучного інтелекту, що робить Інтернет розсадником шахрайства в недалекому майбутньому. Крім того, створення глибоких фейків стає легшим, оскільки ми про це говоримо, що ускладнює пересічному користувачеві Інтернету бути «правильно» поінформованим.

У такій ситуації, коли навряд чи можна зупинити широко поширене зловживання технологією, ми повинні принаймні намагатися бути в курсі.

PS: Що стосується цікавих додатків, то у вас є ці програми deepfake для створення найкращих мемів, які захоплюють соціальні мережі.