Найпоширеніші види шахрайства з використанням deepfake

Давайте розпочнемо з демонстрації, як може виглядати deepfake на прикладі звернення “POTUS” Джо Байдена:

Звучить дещо схоже на можливе голосове шахрайство, створене за допомогою deepfake. Насправді це було згенеровано безплатним інструментом клонування голосу на основі штучного інтелекту. Мені знадобилося лише кілька хвилин, щоб за допомогою ChatGPT написати текст, а потім перетворити його на промову, нібито від імені Байдена.

Проте справжні шахрайства з використанням deepfake є набагато складнішими. Щоб почати, потрібні лише якісні фотографії, відео чи аудіозаписи особи (жертви) і потужна відеокарта.

Мета цієї статті – не навчити вас створювати deepfake-відео і не розглядати способи їх виявлення.

Тут ми коротко ознайомимо вас із технологією deepfake і наведемо приклади найпоширеніших видів шахрайства, яких варто остерігатися.

Що таке Deepfake?

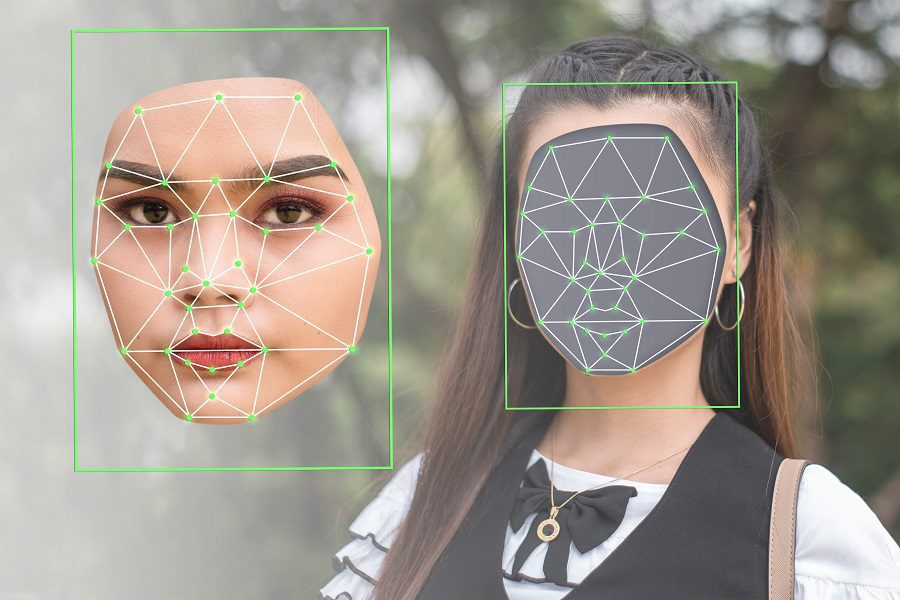

Термін “deepfake” є поєднанням двох слів: “deep” (від глибокого навчання, яке використовується для їх створення) і “fake” (що вказує на підробний характер контенту).

Простіше кажучи, deepfake – це переконливі зображення, аудіо- або відеоматеріали, створені за допомогою алгоритмів глибокого навчання на основі оригінальних даних високої якості.

Наведений вище приклад є класичним deepfake, який виглядає досить правдоподібно. Але варто зазначити, що йому вже п’ять років, а технологія розвивається дуже швидко.

Ця технологія використовується не лише для розваг чи демонстрації можливостей штучного інтелекту. Серйозний випадок – deepfake-відео, де “пан Володимир Зеленський” нібито просив свої війська здатися під час російсько-української війни.

На жаль, це не поодинокий випадок. Згідно з дослідженням Regula Forensics 2023, 37% організацій зіткнулися з голосовим шахрайством на основі deepfake, 29% – з відеошахрайством, а 46% – зі спробами викрадення особистої інформації.

Отже, deepfake – це не лише забавка, а й інструмент для поширення дезінформації та інших шкідливих дій, які можуть бути небезпечними та травмуючими для жертв.

Боротися з контентом deepfake непросто, оскільки це наслідок прогресу в технологіях штучного інтелекту та їх широкої доступності для загального користування.

Тому найкращий захист, який ми маємо – це підвищена обізнаність.

Давайте розглянемо детальніше види шахрайства з використанням deepfake.

Види шахрайства Deepfake

Залежно від мети і способу використання deepfake-шахрайство можна поділити на кілька категорій:

- Відеоімітація

- Фальшиві співбесіди

- Фейкові новини

- Голосове шахрайство

- Медові пастки

- Підтримка клієнтів

- Відгуки

Розглянемо детальніше кожен із цих видів.

Відеоімітація

Це поширений вид deepfake-шахрайства, де створюється фальшиве відео, в якому імітується відома особа. Типовими жертвами можуть бути президенти країн (наприклад, deepfake Обами), знамениті голлівудські актори або керівники відомих компаній.

Публічна доступність їхніх фотографій, відеозаписів промов та інших матеріалів робить їх легкою мішенню. Інструменти для створення deepfake-відео ефективно обробляють різноманітні дані, відтворюючи різні емоції, ракурси обличчя, умови освітлення і фони.

Метою такої імітації може бути як проста розвага, так і шантаж, політична пропаганда, наклеп або інші шкідливі дії.

Іноді deepfake-відео використовуються для того, щоб обманом змусити членів сім’ї переказати гроші або надати доступ до цінних речей.

Фальшиві співбесіди

Фальшиві співбесіди з використанням технології deepfake націлені, як правило, на віддалені робочі місця. Шахраї намагаються відтворити відео deepfake в реальному часі через платформи відеоконференцій, як Zoom.

Окрім того, що компанія-мішень може найняти некваліфікованого кандидата, вона також ризикує розкрити свою конфіденційну інформацію. З огляду на це, під загрозу можуть потрапити не лише ресурси компанії, а й національні інтереси.

Інша мета фальшивих співбесід – отримання грошей під виглядом цінних криптовалют.

Також шахраї можуть вимагати плату за участь у співбесідах, обіцяючи кандидатам зустрічі з “професіоналами” задля отримання роботи їхньої мрії.

Фейкові новини

Найпоширенішим видом deepfake-шахрайства є створення фейкових новин. Такі онлайн-кампанії з дезінформації можуть мати фатальні наслідки в критичних ситуаціях, таких як заворушення чи війни.

Окрім того, вони можуть дискредитувати публічних діячів, приписуючи deepfake-копіям коментарі, яких вони насправді ніколи не робили.

Соціальні мережі та платформи, такі як YouTube, сприяють поширенню таких фальшивих новин, створюючи атмосферу недовіри та плутанини щодо автентичності інформації.

Голосове шахрайство

Аналогічно до відео та зображень, синтезований голос є ще одним інструментом для обману.

Наприклад, жителька Арізони Дженніфер ДеСтефано отримала дзвінок, де нібито її 15-річна донька благала про допомогу, а чоловічий голос вимагав 1 мільйон доларів за її звільнення. Мати була переконана, що її доньці загрожує небезпека. Лише після того, як знайома перевірила інформацію, виявилося, що дочка в безпеці.

За словами ДеСтефано, вона повірила голосу не лише через його звучання, а й через інтонацію, яка точно імітувала голос її дочки.

Таке клонування голосу виконується на основі зразків аудіо з оригінального джерела.

Медові пастки

Традиційно медова пастка – це ситуація, де особу зваблюють у відносини, щоб отримати конфіденційну інформацію. Медові пастки націлені на представників організацій з високим рівнем доступу, таких як військові, високопосадовці, політики.

З технологією deepfake ці пастки переважно існують в онлайн-середовищі, і їх може виконувати будь-хто. Жертви отримують запити на відносини від привабливих партнерів у соціальних мережах, які швидко переростають в інтимні, з кінцевою метою фінансового чи інформаційного вимагання.

Такі deepfake-шахрайства – це довготривалі операції, які займають певний час, перш ніж спрацює пастка.

Підтримка клієнтів

Шахрайство зі службою технічної підтримки є дуже поширеним. Можливо, ви чули про випадки, коли шахраї, видаючи себе за представників “Microsoft”, вимагають гроші за вирішення “серйозних” проблем комп’ютера.

До появи deepfake, акцент або незвичайні моделі мовлення допомагали виявляти їхні обманні дії. Але тепер ці шахраї мають доступ до технологій штучного інтелекту, що дозволяє їм легко обдурювати користувачів, змушуючи їх повірити, що вони спілкуються з легітимним представником компанії.

Відгуки

Багато хто з нас читає відгуки покупців перед придбанням будь-якого товару. Аналогічно, перегляд відеовідгуків є звичною практикою, яка досі була корисною.

Цей вид deepfake-шахрайства використовує фальшиві відеовідгуки, щоб вплинути на рішення клієнтів про покупку і змусити їх витратити гроші на неякісні товари.

І це ще не все!

Що ще ми бачимо в інтернеті окрім тексту?

Відео, зображення та аудіо. Всі ці формати можуть бути підроблені за допомогою технології deepfake, що робить Інтернет потенційним осередком шахрайства в майбутньому. Крім того, створення deepfake стає дедалі простішим, що ускладнює отримання достовірної інформації для звичайних користувачів.

В такій ситуації, коли навряд чи можна зупинити поширене зловживання технологією, ми повинні принаймні намагатися бути обізнаними.

PS: Якщо говорити про цікаві застосування, то є deepfake-програми для створення мемів, які популярні у соціальних мережах.