У сфері сучасного штучного інтелекту (ШІ) навчання з підкріпленням (RL) є однією з найкрутіших тем дослідження. Розробники штучного інтелекту та машинного навчання (ML) також зосереджуються на практиках RL, щоб імпровізувати інтелектуальні програми чи інструменти, які вони розробляють.

Машинне навчання є принципом, що лежить в основі всіх продуктів ШІ. Розробники використовують різні методології ML для навчання своїх інтелектуальних додатків, ігор тощо. ML — це дуже диверсифікована сфера, і різні групи розробників пропонують нові методи навчання машини.

Одним із таких прибуткових методів ML є глибоке навчання з підкріпленням. Тут ви караєте небажану поведінку машини та винагороджуєте бажані дії розумної машини. Експерти вважають, що цей метод машинного навчання змушує ШІ вчитися на власному досвіді.

Продовжуйте читати цей чудовий посібник із методів навчання з підкріпленням для інтелектуальних програм і машин, якщо ви розглядаєте кар’єру в галузі штучного інтелекту та машинного навчання.

Що таке навчання з підкріпленням у машинному навчанні?

RL — це навчання моделей машинного навчання комп’ютерним програмам. Потім програма може прийняти послідовність рішень на основі моделей навчання. Програмне забезпечення вчиться досягати мети в потенційно складному та невизначеному середовищі. У такій моделі машинного навчання ШІ стикається зі сценарієм, схожим на гру.

Додаток зі штучним інтелектом використовує метод проб і помилок, щоб знайти креативне вирішення проблеми. Коли програма AI вивчає правильні моделі ML, вона дає вказівки машині, якою керує, виконувати деякі завдання, які хоче програміст.

За правильне рішення та виконання завдання ШІ отримує винагороду. Однак якщо штучний інтелект робить неправильний вибір, йому загрожує покарання, наприклад втрата бонусних балів. Кінцева мета програми штучного інтелекту – накопичити максимальну кількість бонусних балів для перемоги в грі.

Програміст програми AI встановлює правила гри або політику винагород. Програміст також надає проблему, яку ШІ повинен вирішити. На відміну від інших моделей ML, програма AI не отримує жодних підказок від програміста.

Штучний інтелект має з’ясувати, як вирішувати ігрові завдання, щоб отримати максимальну винагороду. Додаток може використовувати метод проб і помилок, випадкові випробування, навички роботи з суперкомп’ютером і складну тактику розумового процесу для досягнення рішення.

Ви повинні оснастити програму штучного інтелекту потужною обчислювальною інфраструктурою та зв’язати її систему мислення з різноманітними паралельними та історичними процесами гри. Потім штучний інтелект може продемонструвати критичну творчість високого рівня, яку люди не можуть уявити.

Популярні приклади навчання з підкріпленням

#1. Перемога над найкращим гравцем у Human Go

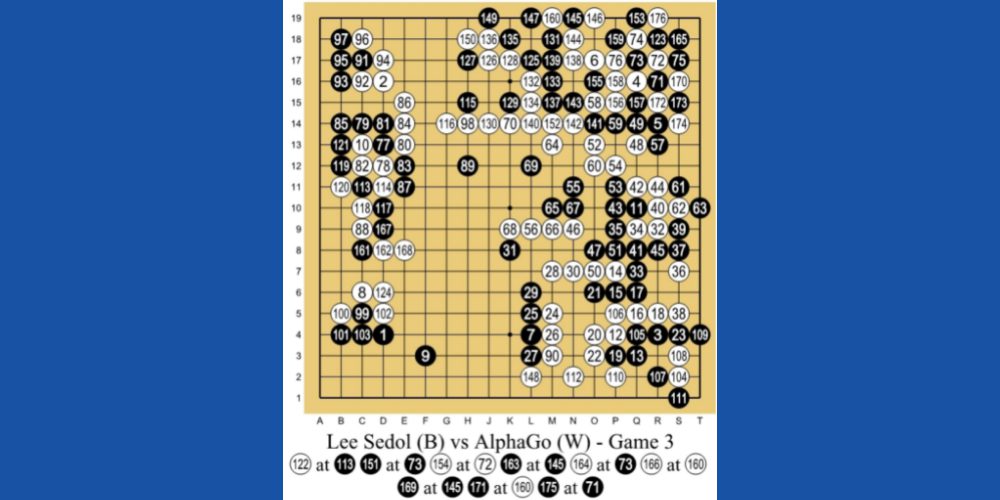

AlphaGo AI від DeepMind Technologies, дочірньої компанії Google, є одним із провідних прикладів машинного навчання на основі RL. ШІ грає в китайську настільну гру Go. Це 3000-річна гра, яка зосереджена на тактиці та стратегії.

Програмісти використовували для AlphaGo метод навчання RL. Він зіграв тисячі сеансів ігор Go з людьми та собою. Потім у 2016 році він переміг найкращого у світі гравця Го Лі Се-Дола в матчі один на один.

#2. Робототехніка в реальному світі

Люди вже давно використовують робототехніку на виробничих лініях, де завдання заздалегідь сплановані та повторюються. Але якщо вам потрібно зробити універсального робота для реального світу, де дії не плануються заздалегідь, то це великий виклик.

Але штучний інтелект з підтримкою навчання може знайти плавний, навігаційний і короткий маршрут між двома місцями.

#3. Безпілотні транспортні засоби

Дослідники автономних транспортних засобів широко використовують метод RL, щоб навчати свій ШІ:

- Динамічний шлях

- Оптимізація траєкторії

- Планування руху, наприклад паркування та зміна смуги руху

- Контролери оптимізації, (електронний блок керування) ECU, (мікроконтролери) MCU тощо.

- Сценарне навчання на автострадах

#4. Автоматизовані системи охолодження

ШІ на основі RL може допомогти мінімізувати споживання енергії системами охолодження в гігантських офісних будівлях, бізнес-центрах, торгових центрах і, що особливо важливо, в центрах обробки даних. AI збирає дані з тисяч теплових датчиків.

Він також збирає дані про діяльність людей і машин. На основі цих даних штучний інтелект може передбачити майбутній потенціал виробництва тепла та належним чином вмикати та вимикати системи охолодження для економії енергії.

Як налаштувати модель навчання з підкріпленням

Ви можете налаштувати модель RL на основі таких методів:

#1. На основі політики

Цей підхід дозволяє програмісту ШІ знайти ідеальну політику для максимальної винагороди. Тут програміст не використовує функцію значення. Після встановлення методу на основі політики агент навчання з посиленням намагається застосувати політику так, щоб дії, які він виконує на кожному кроці, дозволяли ШІ максимізувати бали винагороди.

В основному існує два типи політики:

#1. Детермінований: політика може призвести до однакових дій у будь-якому заданому стані.

#2. Стохастичний: вироблені дії визначаються ймовірністю виникнення.

#2. На основі цінностей

Навпаки, підхід, заснований на цінностях, допомагає програмісту знайти оптимальну функцію значення, яка є максимальним значенням за політикою в будь-якому даному стані. Після застосування агент RL очікує довгострокового прибутку в будь-якому одному або кількох станах відповідно до зазначеної політики.

#3. На основі моделі

У підході RL на основі моделі програміст ШІ створює віртуальну модель середовища. Потім агент RL переміщується в середовищі та навчається в ньому.

Типи навчання з підкріпленням

#1. Навчання з позитивним підкріпленням (PRL)

Позитивне навчання означає додавання деяких елементів для підвищення ймовірності того, що очікувана поведінка повториться. Цей метод навчання позитивно впливає на поведінку агента RL. PRL також покращує силу певної поведінки вашого ШІ.

PRL-тип підкріплення навчання має підготувати ШІ до адаптації до змін протягом тривалого часу. Але надто багато позитивного навчання може призвести до надмірного навантаження станами, що може знизити ефективність ШІ.

#2. Навчання з негативним підкріпленням (NRL)

Коли алгоритм RL допомагає штучному інтелекту уникнути або зупинити негативну поведінку, він вчиться на цьому та покращує свої майбутні дії. Це відоме як негативне навчання. Він надає штучному інтелекту лише обмежений інтелект, щоб відповідати певним поведінковим вимогам.

Реальні випадки використання навчання з підкріпленням

#1. Розробники рішень для електронної комерції створили персоналізовані інструменти для пропонування продуктів або послуг. Ви можете підключити API інструмента до свого сайту онлайн-покупок. Потім штучний інтелект навчатиметься від окремих користувачів і пропонуватиме спеціальні товари та послуги.

#2. Відеоігри з відкритим світом пропонують безмежні можливості. Однак за ігровою програмою стоїть програма штучного інтелекту, яка вивчає дані гравців і змінює код відеоігри для адаптації до невідомої ситуації.

#3. Торгівля акціями та інвестиційні платформи на основі ШІ використовують модель RL, щоб вивчати рух акцій і глобальних індексів. Відповідно, вони формулюють ймовірнісну модель, щоб запропонувати акції для інвестицій або торгівлі.

#4. Інтернет-відеотеки, такі як YouTube, Metacafe, Dailymotion тощо, використовують ботів AI, навчених на моделі RL, щоб пропонувати своїм користувачам персоналізовані відео.

Навчання з підкріпленням проти. Контрольоване навчання

Навчання з підкріпленням має на меті навчити агента ШІ приймати рішення послідовно. У двох словах, ви можете вважати, що вихід ШІ залежить від стану поточного входу. Подібним чином, наступний вхідний сигнал для алгоритму RL залежатиме від результату попередніх вхідних даних.

Роботизована машина на основі ШІ, яка грає в шахи проти людини-шахіста, є прикладом моделі машинного навчання RL.

Навпаки, під час навчання під наглядом програміст навчає агента штучного інтелекту приймати рішення на основі вхідних даних, наданих на початку або будь-яких інших початкових вхідних даних. Штучний інтелект автономного керування автомобілем, який розпізнає об’єкти навколишнього середовища, є чудовим прикладом навчання під наглядом.

Навчання з підкріпленням проти. Навчання без контролю

Наразі ви зрозуміли, що метод RL змушує агента штучного інтелекту вивчати політику моделі машинного навчання. В основному штучний інтелект робитиме лише ті кроки, за які він отримує максимальну кількість бонусних балів. RL допомагає ШІ імпровізувати шляхом проб і помилок.

З іншого боку, під час неконтрольованого навчання програміст штучного інтелекту вводить програмне забезпечення штучного інтелекту з даними без міток. Крім того, інструктор ML не повідомляє штучному інтелекту нічого про структуру даних або про те, що шукати в даних. Алгоритм вивчає різні рішення шляхом каталогізації власних спостережень щодо заданих невідомих наборів даних.

Курси підкріплення

Тепер, коли ви вивчили основи, ось кілька онлайн-курсів, щоб вивчити поглиблене навчання з підкріпленням. Ви також отримуєте сертифікат, який можете продемонструвати на LinkedIn або інших соціальних платформах:

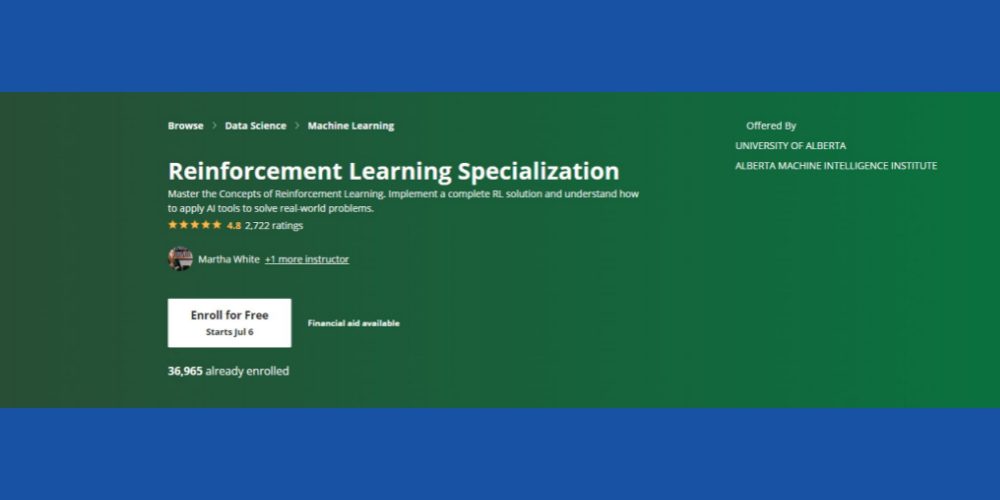

Спеціалізація навчання з підкріпленням: Coursera

Хочете освоїти основні концепції навчання з підкріпленням у контексті ML? Ви можете спробувати це Курс Coursera RL який доступний онлайн і включає можливість самостійного навчання та сертифікації. Курс підійде вам, якщо ви принесете наступні базові навички:

- Знання програмування на Python

- Основні статистичні поняття

- Ви можете конвертувати псевдокоди та алгоритми в коди Python

- Досвід розробки програмного забезпечення від двох до трьох років

- Студенти другого курсу з інформатики також мають право

Курс має рейтинг 4,8 зірки, і понад 36 тисяч студентів уже записалися на курс на різних курсах. Крім того, курс передбачає фінансову допомогу за умови, що кандидат відповідає певним критеріям прийнятності Coursera.

Нарешті, Інститут машинного інтелекту Альберти Університету Альберти пропонує цей курс (залік не надається). Шановні професори в галузі інформатики будуть працювати як викладачі курсу. Після завершення курсу ви отримаєте сертифікат Coursera.

AI Reinforcement Learning у Python: Udemy

Якщо ви займаєтеся фінансовим ринком або цифровим маркетингом і хочете розробити інтелектуальні пакети програмного забезпечення для зазначених сфер, вам слід ознайомитися з цим Удемий курс на РЛ. Окрім основних принципів RL, зміст навчання також навчить вас, як розробляти RL-рішення для онлайн-реклами та біржової торгівлі.

Деякі відомі теми, які охоплює курс:

- Загальний огляд RL

- Динамічне програмування

- Моне Карло

- Методи апроксимації

- Проект біржової торгівлі з RL

Понад 42 тисячі студентів вже відвідали курс. Навчальний онлайн-ресурс наразі має рейтинг 4,6 зірки, що є досить вражаючим. Більше того, курс спрямований на обслуговування світової студентської спільноти, оскільки навчальний контент доступний французькою, англійською, іспанською, німецькою, італійською та португальською мовами.

Глибоке підсилювальне навчання в Python: Udemy

Якщо у вас є допитливість і ви маєте базові знання про глибоке навчання та штучний інтелект, ви можете спробувати цей розширений Курс RL на Python від Udemy. З рейтингом 4,6 зірки від студентів, це ще один популярний курс для вивчення RL у контексті AI/ML.

Курс складається з 12 розділів і охоплює наступні актуальні теми:

- OpenAI Gym і основні техніки RL

- ТД Лямбда

- A3C

- Основи Теано

- Основи Tensorflow

- Кодування Python для початківців

Весь курс вимагатиме інвестування 10 годин 40 хвилин. Окрім текстів, він також містить 79 експертних лекцій.

Експерт із глибокого підкріплення навчання: Udacity

Хочете навчитися вдосконаленому машинному навчанню від світових лідерів у сфері ШІ/ML, таких як Nvidia Deep Learning Institute і Unity? Udacity дозволяє здійснити вашу мрію. Подивіться це Глибоке навчання з підкріпленням курс стати експертом з ML.

Однак вам потрібно мати досвід розвиненого Python, проміжної статистики, теорії ймовірностей, TensorFlow, PyTorch і Keras.

Щоб завершити курс, знадобиться наполегливе навчання до 4 місяців. Протягом курсу ви дізнаєтесь про життєво важливі алгоритми RL, як-от глибокі детерміновані градієнти політики (DDPG), глибокі Q-мережі (DQN) тощо.

Заключні слова

Навчання з підкріпленням є наступним кроком у розвитку ШІ. Агентства з розробки штучного інтелекту та ІТ-компанії вкладають інвестиції в цей сектор, щоб створити надійні та надійні методи навчання ШІ.

Хоча RL значно просунувся вперед, є більше можливостей розвитку. Наприклад, окремі агенти RL не діляться знаннями між собою. Тому, якщо ви навчаєте додаток керувати автомобілем, процес навчання буде повільним. Оскільки такі агенти RL, як виявлення об’єктів, посилання на дороги тощо, не обмінюватимуться даними.

Є можливості вкласти свій творчий потенціал і досвід ML у такі завдання. Реєстрація на онлайн-курси допоможе вам поглибити свої знання про передові методи RL та їх застосування в реальних проектах.

Ще одна пов’язана інформація для вас – це відмінності між штучним інтелектом, машинним навчанням і глибоким навчанням.