Алгоритмічні упередження здатні впливати на різноманітні сфери нашого існування, починаючи від рекомендацій контенту в мережі Інтернет і закінчуючи процесами пошуку роботи та фінансовими рішеннями.

Упередження – це невід’ємна складова людської натури. Кожна людина відрізняється унікальною комбінацією статі, раси, виховання, освіти, культурного середовища, вірувань та життєвого досвіду.

Саме тому їхні погляди, думки, симпатії, антипатії та преференції є різними. У зв’язку з цим, у них можуть формуватися певні упередження щодо окремих категорій або навпаки.

Машини в цьому плані не є винятком. Вони також можуть сприймати людей, речі та події під різним кутом через упередження, які вбудовані в їхні алгоритми. Такі упередження можуть призводити до несправедливих результатів, створюваних системами штучного інтелекту та машинного навчання, що, своєю чергою, може завдавати шкоди людям у багатьох аспектах їхнього життя.

У цій статті ми розглянемо, що являють собою алгоритмічні упередження, їхні різновиди, а також методи їхнього виявлення та зменшення для досягнення більшої справедливості результатів.

Отже, почнемо!

Що таке алгоритмічні упередження?

Алгоритмічне упередження – це схильність алгоритмів машинного навчання та штучного інтелекту відображати людські упередження, що призводить до несправедливих результатів. Ці упередження можуть базуватися на гендері, віці, расі, релігії, етнічній приналежності, культурі та інших факторах.

У контексті штучного інтелекту та машинного навчання алгоритмічні упередження – це систематичні та повторювані помилки, які впроваджуються в систему, спричиняючи несправедливі результати.

Упередження в алгоритмах можуть виникати з різних причин, включаючи рішення, пов’язані зі збором даних, їхнім відбором, кодуванням або використанням для навчання алгоритму, цільовим призначенням, дизайном алгоритму тощо.

Наприклад, можна спостерігати алгоритмічні упередження в результатах пошукових систем, що може призводити до порушення конфіденційності, посилення соціальних упереджень та інших проблем.

Існує чимало випадків прояву алгоритмічних упереджень у різних сферах, таких як результати виборів, поширення мови ненависті в Інтернеті, охорона здоров’я, кримінальне правосуддя, найм на роботу. Це посилює існуючі упередження, пов’язані зі статтю, расою, економічним становищем та суспільством в цілому.

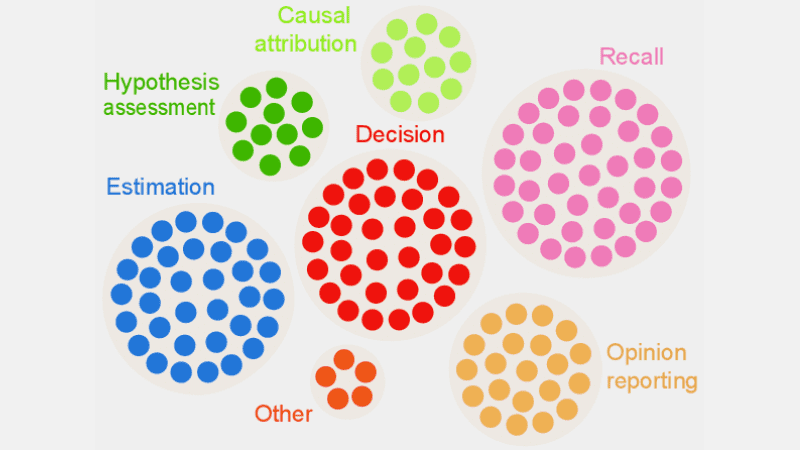

Типи алгоритмічних упереджень

#1. Упередження даних

Упередження даних виникає, коли дані, необхідні для навчання моделі штучного інтелекту, невірно відображають реальні ситуації або населення. Це може призводити до незбалансованих або спотворених наборів даних.

Джерело: TELUS International

Джерело: TELUS International

Наприклад, якщо програмне забезпечення для розпізнавання облич навчається переважно на зображеннях людей з білим кольором шкіри, воно може некоректно працювати при розпізнаванні осіб з темнішим відтінком шкіри, створюючи проблеми для цих людей.

#2. Упередження вимірювання

Це упередження виникає через недоліки в процесі вимірювання або збору даних.

Наприклад, якщо навчати діагностичний алгоритм охорони здоров’я виявляти хворобу на основі таких показників, як попередні візити до лікаря, це може спотворити оцінку стану пацієнта, приховуючи справжні симптоми.

#3. Упередження моделі

Упередження моделі з’являються під час розробки алгоритму або моделі штучного інтелекту.

Припустімо, що система штучного інтелекту має алгоритм, розроблений для максимізації прибутку будь-яким способом. У такому випадку, вона може надавати перевагу фінансовим прибуткам за рахунок ділової етики, безпеки та справедливості.

#4. Упередження оцінки

Упередження оцінки може виникати, коли фактори або критерії, що використовуються для оцінки ефективності системи штучного інтелекту, є упередженими.

Джерело: Clear Review

Джерело: Clear Review

Наприклад, якщо система оцінювання продуктивності штучного інтелекту застосовує стандартні тести, які ставлять у вигідне становище певну категорію співробітників, це може призвести до нерівності.

#5. Упередження звітності

Упередження звітності виникає, коли набір даних для навчання не точно відображає реальну частоту подій.

Наприклад, якщо інструмент безпеки на базі штучного інтелекту погано працює в певній категорії, він може позначити всю категорію як підозрілу.

Це означає, що набір даних, на якому навчалася система, позначав кожен історичний інцидент, пов’язаний з цією категорією, як небезпечний через більшу частоту інцидентів.

#6. Упередження відбору

Упередження відбору виникає, коли навчальні дані відбираються без належної рандомізації або не є репрезентативними для всієї сукупності.

Наприклад, якщо інструмент розпізнавання облич навчено на обмеженому обсязі даних, він може почати демонструвати певну дискримінацію, наприклад, гірше ідентифікувати жінок небілого походження у політиці, ніж чоловіків, та людей зі світлою шкірою.

#7. Неявне упередження

Неявне упередження виникає, коли алгоритм штучного інтелекту робить висновки, опираючись на особистий досвід, який може бути непридатним для широкого загалу.

Наприклад, якщо фахівець з обробки даних, який розробляє алгоритм штучного інтелекту, вважає, що жінкам найбільше подобається рожевий колір, а не синій або чорний, то система може рекомендувати товари, виходячи з цього припущення, що, звісно, не стосується кожної жінки.

#8. Групове упередження атрибуції

Це упередження може проявлятися, коли розробники алгоритмів застосовують характеристики, притаманні певним особам, до всієї групи, незалежно від того, чи належать до неї ці особи. Групове упередження атрибуції часто зустрічається в інструментах найму та прийому на роботу.

Наприклад, інструмент відбору може надавати перевагу кандидатам з певної школи, дискримінуючи інших студентів, які не є випускниками цієї установи.

#9. Історичне упередження

Збір історичних наборів даних є важливим при навчанні алгоритмів машинного навчання. Однак, якщо не приділяти цьому достатньо уваги, то в алгоритмах може виникнути упередження, зумовлене історичними даними.

Наприклад, якщо ви навчаєте модель штучного інтелекту на історичних даних за 10 років для формування списку кандидатів на технічні посади, вона може надавати перевагу кандидатам-чоловікам, якщо навчальні дані містять більшу кількість чоловіків, ніж жінок.

#10. Упередження маркування

Під час навчання алгоритмів машинного навчання може знадобитися маркувати велику кількість даних. Однак, процес маркування може суттєво відрізнятися, створюючи невідповідності та вносячи упередження в систему штучного інтелекту.

Наприклад, якщо ви навчаєте алгоритм штучного інтелекту, позначаючи котів на зображеннях за допомогою рамок, то, якщо не будете уважні, алгоритм може не розпізнати кота на зображенні, якщо його морда не видно, але зможе ідентифікувати зображення з мордами котів.

Це означає, що алгоритм має упередження у визначенні зображень з котами, що дивляться прямо. Він не може ідентифікувати кота, якщо зображення зроблено під іншим кутом, коли видно тіло, але не морду.

#11. Упередження виключення

Джерело: ResearchGate

Джерело: ResearchGate

Упередження виключення виникає, коли конкретна особа, група людей або категорія навмисно або ненавмисно виключаються під час збору даних, оскільки вони вважаються нерелевантними. Найчастіше це відбувається на етапі підготовки даних у життєвому циклі машинного навчання під час очищення та підготовки даних до використання.

Наприклад, якщо система прогнозування на основі штучного інтелекту має визначити популярність певного продукту протягом зимового сезону, аналізуючи обсяги покупок, і фахівець з обробки даних видалить записи про покупки у жовтні, вважаючи їх помилковими, а за основу візьме стандартний період з листопада по січень, то алгоритм буде зміщений на користь країн, де зима припадає саме на ці місяці.

Як упередження впроваджуються в алгоритми?

Навчальні дані

Головним джерелом алгоритмічних упереджень є упереджені дані, що використовуються для навчання алгоритмів штучного інтелекту та машинного навчання. Якщо самі навчальні дані містять елементи нерівності та упереджень, алгоритм їх засвоїть і збереже упередження.

Дизайн

При розробці алгоритму, розробник може свідомо чи несвідомо закласти в систему штучного інтелекту відображення особистих поглядів або уподобань. Таким чином, система штучного інтелекту буде упереджена щодо певних категорій.

Прийняття рішень

Нерідко дослідники даних і керівники приймають рішення, ґрунтуючись на власному досвіді, оточенні та переконаннях. Ці рішення також можуть впливати на алгоритми, викликаючи упередження.

Брак різноманітності

Через відсутність різноманітності в команді розробників, члени команди створюють алгоритми, які не є репрезентативними для всієї сукупності. Вони не мають досвіду або знайомства з іншими культурами, походженням, переконаннями, способами життя тощо, тому їхні алгоритми можуть бути упередженими.

Попередня обробка даних

Метод, що використовується для очищення та обробки даних, може внести алгоритмічне упередження. Якщо ці методи не розроблені ретельно для протидії упередженням, це може стати серйозною проблемою в моделі штучного інтелекту.

Архітектура

Архітектура моделі та тип алгоритму машинного навчання, який ви вибрали, також можуть спричинити упередження. Деякі алгоритми більш схильні до упереджень, ніж інші, залежно від їхнього дизайну.

Вибір ознак

Ознаки, які ви використовуєте для навчання алгоритму штучного інтелекту, також є однією з причин упередження. Якщо ви не вибираєте ознаки, враховуючи їхній вплив на справедливість результату, може виникнути упередження, що надаватиме перевагу певним категоріям.

Історія та культура

Якщо алгоритм живиться і навчається на даних, отриманих з історії або певних культур, він може успадкувати упередження, такі як переконання, норми тощо. Ці упередження можуть вплинути на результати штучного інтелекту, навіть якщо вони є несправедливими та неактуальними в сьогоденні.

Дрейф даних

Дані, що використовуються сьогодні для навчання алгоритмів штучного інтелекту, з часом можуть стати неактуальними, некорисними або застарілими через зміни в технологіях або суспільстві. Однак ці набори даних все ще можуть вносити упередження та знижувати ефективність.

Петлі зворотного зв’язку

Деякі системи штучного інтелекту можуть не лише взаємодіяти з користувачами, але й адаптуватися до їхньої поведінки. Таким чином, алгоритм може посилювати існуюче упередження. Коли особисті упередження користувачів впливають на систему штучного інтелекту, це може створити цикл упередженого зворотного зв’язку.

Як виявити алгоритмічне упередження?

Визначте, що таке “справедливо”

Щоб виявити несправедливі результати або упередження в алгоритмах, потрібно спочатку визначити, що саме означає «справедливо» для системи штучного інтелекту. Для цього можна враховувати такі фактори, як стать, вік, раса, сексуальність, регіон, культура тощо.

Слід визначити показники для обчислення справедливості, такі як рівні можливості, прогнозний паритет, вплив тощо. Після визначення поняття «справедливості» буде легше виявити те, що є несправедливим, та вирішити проблему.

Аудит навчальних даних

Необхідно ретельно проаналізувати навчальні дані для виявлення дисбалансів та невідповідностей у представленні різних категорій. Слід вивчити розподіл ознак та перевірити, чи відповідає він реальним демографічним показникам.

Для візуалізації даних можна створювати гістограми, теплові карти, діаграми розсіювання, щоб виділити розбіжності та закономірності, які можуть бути непомітними при використанні лише статистичного аналізу.

Крім внутрішнього аудиту, можна залучати зовнішніх експертів та аудиторів для оцінки упереджень системи.

Вимірювання продуктивності моделі

Для виявлення упереджень варто вимірювати продуктивність моделі штучного інтелекту для різних демографічних груп і категорій. Буде корисно розділити навчання на різні групи за расою, статтю тощо. Також можна використовувати показники справедливості для обчислення відмінностей у результатах.

Використовуйте відповідні алгоритми

Необхідно вибирати алгоритми, які сприяють отриманню справедливих результатів і можуть усунути упередження під час навчання моделі штучного інтелекту. Алгоритми, орієнтовані на справедливість, запобігають упередженням, забезпечуючи однакові прогнози для різних категорій.

Програмне забезпечення для виявлення упереджень

Для виявлення упереджень можна використовувати спеціалізовані інструменти та бібліотеки, що враховують питання справедливості. Ці інструменти пропонують показники справедливості, візуалізації, статистичні тести для виявлення упереджень. Серед популярних — AI Fairness 360 та IBM Fairness 360.

Отримання відгуків користувачів

Запитуйте користувачів про їхні враження від системи штучного інтелекту. Заохочуйте їх ділитися відгуками, якщо вони зіткнулися з несправедливим ставленням або упередженням з боку системи. Ці дані допоможуть виявити проблеми, які можуть бути не помічені автоматизованими інструментами.

Як зменшити упередження в алгоритмах

Диверсифікація вашої компанії

Створення різноманітності в компанії та команді розробників сприяє швидшому виявленню та усуненню упереджень. Причина полягає в тому, що упередження найчастіше помічають ті користувачі, на яких вони впливають.

Тому потрібно диверсифікувати компанію не лише за демографічними показниками, а й за допомогою навичок та досвіду. Необхідно включати людей різної статі, ідентичності, раси, кольору шкіри, економічного становища тощо, а також людей з різним освітнім досвідом та походженням.

Таким чином, можна отримати різноманітні перспективи, досвід, культурні цінності, уподобання та антипатії, що сприятиме підвищенню справедливості алгоритмів штучного інтелекту шляхом зменшення упереджень.

Забезпечення прозорості

Будьте прозорими зі своєю командою щодо цілей, алгоритмів, джерел даних і рішень системи штучного інтелекту. Це дозволить користувачам зрозуміти, як працює система штучного інтелекту та чому вона дає певні результати, що сприятиме довірі.

Алгоритми, орієнтовані на справедливість

Слід використовувати алгоритми, орієнтовані на справедливість під час розробки моделі, щоб забезпечити отримання справедливих результатів для різних категорій. Це особливо важливо при створенні систем штучного інтелекту для суворо регульованих галузей, таких як фінанси та охорона здоров’я.

Оцінка продуктивності моделі

Необхідно перевіряти моделі для оцінки продуктивності штучного інтелекту в різних групах та підгрупах. Це допоможе виявити проблеми, які непомітні в сукупних показниках. Також можна імітувати різні сценарії для перевірки їхньої ефективності, включаючи складні ситуації.

Дотримання етичних принципів

Розробіть етичні принципи розробки систем штучного інтелекту, поважаючи справедливість, конфіденційність, безпеку та права людини. Слід забезпечити дотримання цих принципів в організації, щоб справедливість відображалася на результатах роботи системи штучного інтелекту.

Встановлення контролю та відповідальності

Потрібно встановити чіткі обов’язки для кожного члена команди, що працює над розробкою, обслуговуванням та розгортанням системи штучного інтелекту. Також слід запровадити відповідні засоби контролю зі строгими протоколами та рамками для усунення упереджень, помилок та інших проблем.

Крім цього, необхідно проводити регулярні перевірки для зменшення упереджень та прагнути до постійного вдосконалення. Крім того, слід постійно стежити за останніми змінами в технологіях, демографії та інших факторах.

Реальні приклади алгоритмічних упереджень

#1. Алгоритм Amazon

Amazon – лідер у галузі електронної комерції. Однак їхній інструмент для найму, що використовував штучний інтелект для оцінювання кандидатів на роботу, виявив гендерні упередження. Ця система штучного інтелекту була навчена на резюме попередніх кандидатів на технічні посади.

На жаль, у даних було більше кандидатів чоловічої статі, що стало відомо штучному інтелекту. Таким чином, він несвідомо надавав перевагу кандидатам-чоловікам на технічні посади, ніж жінкам. У 2017 році Amazon був змушений припинити роботу інструменту, незважаючи на зусилля, спрямовані на зменшення упереджень.

#2. Расистські алгоритми охорони здоров’я США

Алгоритм, який використовували американські лікарні для прогнозування пацієнтів, що потребують додаткової допомоги, мав значне упередження проти темношкірих пацієнтів. Система оцінювала медичні потреби пацієнтів на основі їхньої історії витрат на медичне обслуговування, поєднуючи вартість із медичними потребами.

Алгоритм системи не враховував, як білі та темношкірі пацієнти оплачували свої потреби в охороні здоров’я. Чорношкірі пацієнти переважно платили за невідкладну допомогу, навіть при наявності хронічних захворювань. В результаті їх відносили до категорії здоровіших пацієнтів і вони не мали права на додаткову допомогу порівняно з білими пацієнтами.

#3. Дискримінаційний алгоритм Google

Онлайн-рекламна система Google була визнана дискримінаційною. Було виявлено, що реклама висооплачуваних посад, таких як генеральні директори, показується чоловікам значно частіше, ніж жінкам. Навіть якщо 27% генеральних директорів у США – жінки, їхнє представництво в Google є значно меншим, близько 11%.

Алгоритм міг показувати такі результати, вивчаючи поведінку користувачів, наприклад, якщо люди, які переглядають і натискають на рекламу високооплачуваних посад, є чоловіками, алгоритм штучного інтелекту частіше показуватиме цю рекламу чоловікам, ніж жінкам.

Висновок

Алгоритмічні упередження в системах машинного навчання та штучного інтелекту можуть призводити до несправедливих результатів. Ці результати можуть впливати на людей у різних сферах, від охорони здоров’я, кібербезпеки та електронної комерції до виборів, працевлаштування тощо. Це може спричиняти дискримінацію за ознаками статі, раси, демографії, сексуальної орієнтації та інших аспектів.

Тому важливо зменшити упередження в алгоритмах штучного інтелекту та машинного навчання, щоб сприяти справедливості результатів. Наведена інформація допоможе виявити упередження та зменшити їх, щоб створити справедливі системи штучного інтелекту для користувачів.

Також можна ознайомитися з матеріалами щодо управління штучним інтелектом.