Зацікавлені в тому, як отримувати надійну та стабільну інформацію для аналізу? Ознайомтеся з цими методами очищення даних!

Успіх вашого бізнесу залежить від якісного аналізу. Аналогічно, висновки, отримані з вхідних масивів даних, тісно пов’язані з якістю вихідної інформації. Неякісні, неточні, зашумлені та суперечливі джерела є серйозними викликами для фахівців з науки про дані та аналітики.

Тому експерти розробили методи вирішення цієї проблеми. Одним з таких методів є очищення даних. Цей процес запобігає прийняттю рішень, заснованих на неякісних даних, які можуть завдати шкоди вашому бізнесу замість того, щоб покращити його.

Читайте далі, щоб дізнатися про найкращі стратегії очищення даних, які використовують досвідчені фахівці з науки про дані та аналітики. Дослідіть інструменти, які допоможуть вам отримувати точні дані для ваших аналітичних проєктів.

Що таке очищення даних?

Якість даних визначається п’ятьма основними параметрами. Процес виявлення та виправлення помилок у вхідних даних відповідно до встановлених стандартів якості називається очищенням даних.

П’ять основних параметрів якості даних:

#1. Повнота

Цей параметр гарантує, що вхідні дані містять усі необхідні елементи, такі як заголовки, рядки, стовпці, таблиці, що потрібні для вашого аналітичного проєкту.

#2. Точність

Цей показник вказує наскільки дані близькі до їх справжніх значень. Дані вважаються точними, якщо вони відповідають усім статистичним стандартам, що застосовуються під час опитувань або збору інформації.

#3. Валідність

Цей параметр перевіряє відповідність даних бізнес-правилам, які ви встановили.

#4. Однорідність

Однорідність підтверджує, що дані мають однакову структуру та зміст. Наприклад, дані про споживання енергії в США мають бути подані в імперській системі вимірювання. Використання метричної системи для деяких даних зробить набір неоднорідним.

#5. Послідовність

Послідовність гарантує узгодженість значень даних між різними таблицями, моделями даних і наборами. Особливу увагу цьому параметру потрібно приділяти під час передачі даних між різними системами.

Застосуйте ці методи контролю якості до необроблених наборів даних та очистіть їх перед використанням у інструментах бізнес-аналітики.

Чому очищення даних є важливим?

Ви не можете вести бізнес, використовуючи низькоякісний інтернет-зв’язок. Так само, не можна приймати важливі рішення, якщо якість даних є неприйнятною. Використання неякісної інформації для прийняття бізнес-рішень призведе до втрати прибутку або низької рентабельності інвестицій.

Згідно зі звітом Gartner про наслідки низької якості даних, виявлено, що в середньому бізнес втрачає 12,9 мільйона доларів через прийняття рішень на основі помилкових даних.

Той же звіт стверджує, що використання неякісних даних коштує США близько 3 трильйонів доларів щорічних збитків.

Якщо ви подасте неякісну інформацію в систему бізнес-аналітики, результати будуть також неякісними.

Тому, для уникнення фінансових втрат та прийняття ефективних рішень, необхідно очищати необроблені дані перед їхнім використанням в аналітичних проєктах.

Переваги очищення даних

#1. Запобігання фінансовим втратам

Очищення вхідних даних дозволяє захистити вашу компанію від фінансових втрат, штрафів за недотримання норм і втрати клієнтів.

#2. Прийняття обґрунтованих рішень

Якісні дані надають цінну інформацію. Ця інформація допоможе вам приймати важливі рішення у сферах маркетингу, продажів, управління запасами, ціноутворення тощо.

#3. Перевага над конкурентами

Використовуючи очищення даних раніше за конкурентів, ви отримаєте перевагу на ринку.

#4. Ефективність проєкту

Оптимізований процес очищення підвищує довіру членів команди. Оскільки вони впевнені у надійності даних, вони можуть більше зосередитися на їхньому аналізі.

#5. Економія ресурсів

Очищення та скорочення даних зменшує розмір бази даних. Таким чином, ви звільняєте місце для зберігання, видаляючи непотрібні дані.

Стратегії очищення даних

Стандартизуйте представлення даних

Набір даних містить різні типи символів, такі як текст, цифри, спеціальні знаки. Необхідно застосувати однаковий формат (регістр літер) для всіх текстових даних. Переконайтеся, що символи мають правильне кодування, наприклад Unicode або ASCII.

Наприклад, слово “Bill” з великої літери позначає ім’я. У той же час, слово “bill” (рахунок) позначає фінансовий документ. Тому правильне форматування великих літер є важливим.

Видалення дублікатів

Дублікати даних можуть заплутати систему бізнес-аналітики, спотворюючи результати. Тому необхідно виключити повторювані записи з вхідної бази даних.

Дублікати найчастіше виникають через ручне введення даних. Автоматизація процесу введення дозволить уникнути повторення даних.

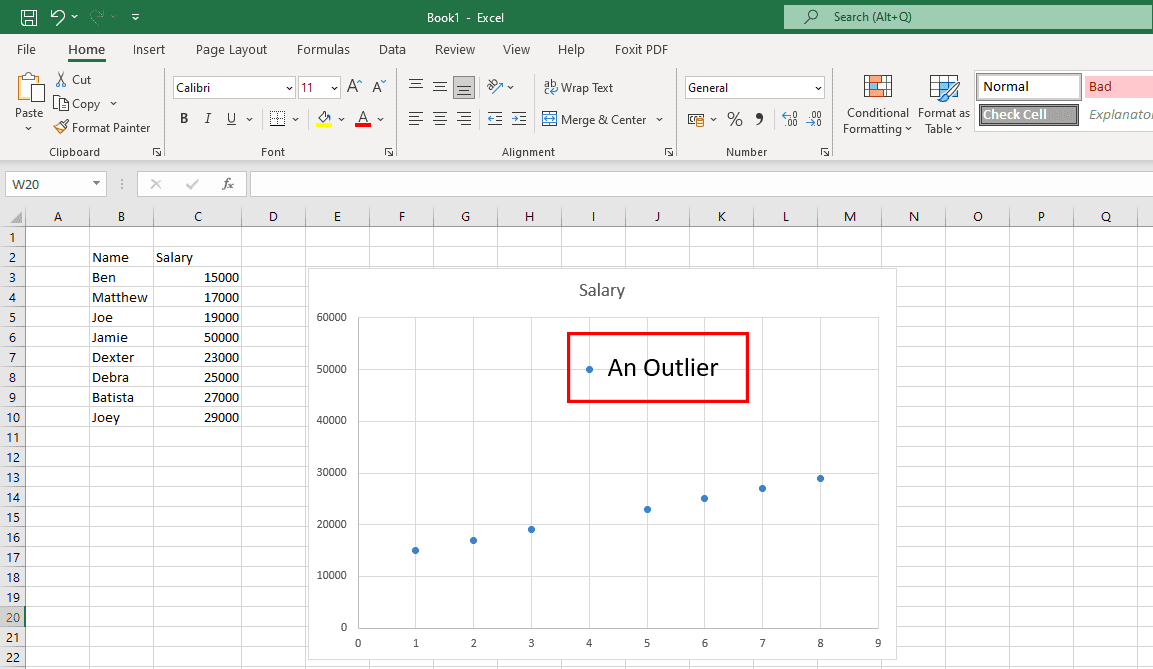

Виправлення небажаних викидів

Викиди – це нетипові дані, які відхиляються від основної тенденції. Викиди можуть бути корисними для виявлення недоліків у опитуваннях. Однак, якщо вони з’являються через людські помилки, це стає проблемою.

Щоб знайти викиди, потрібно візуалізувати дані на графіках. Якщо ви виявите їх, потрібно дослідити їхнє джерело. Якщо вони виникли через людську помилку, їх потрібно видалити.

Структурування даних

Здебільшого, це пошук і виправлення помилок у структурі наборів даних.

Наприклад, набір даних містить стовпці в доларах США та інших валютах. Якщо ваші дані призначені для аудиторії США, конвертуйте інші валюти в долари США та замініть усі інші валюти на долари.

Сканування даних

Велика база даних може містити тисячі таблиць. Не всі вони можуть знадобитися для вашого проєкту.

Отже, після отримання бази даних, потрібно написати сценарій, щоб визначити потрібні таблиці. Після цього ви можете видалити зайві таблиці, зменшивши розмір набору даних.

Це прискорить процес виявлення закономірностей.

Очищення даних у хмарі

Якщо ваша база даних використовує схему при записі, потрібно перетворити її на схему при читанні. Це дозволить очищати дані безпосередньо у хмарному сховищі та видобувати відформатовані, впорядковані та готові до аналізу дані.

Переклад іноземних мов

Якщо ви проводите опитування в різних країнах, у необроблених даних можуть траплятися іноземні мови. Перекладіть рядки та стовпці, що містять іноземні мови, на англійську або будь-яку іншу потрібну мову. Для цього можна використовувати засоби автоматичного перекладу.

Покроковий процес очищення даних

#1. Визначення важливих полів даних

Сховища даних містять терабайти інформації. Кожна база даних може містити від кількох до тисяч стовпців. Перегляньте цілі вашого проєкту та виберіть відповідні дані.

Якщо ваш проєкт вивчає тенденції онлайн-покупок мешканців США, збір даних про офлайн-магазини не буде корисним.

#2. Організація даних

Після того, як ви знайшли важливі поля даних, заголовки стовпців та таблиці, впорядкуйте їх.

#3. Видалення дублікатів

У необроблених даних завжди є повторювані записи. Виявіть та видаліть їх.

#4. Усунення порожніх значень та пробілів

Деякі заголовки стовпців та відповідні їм поля можуть не містити значень. Видаліть ці заголовки/поля або замініть порожні значення на правильні буквено-цифрові дані.

#5. Тонке форматування

Набори даних можуть містити непотрібні пробіли та символи. Відформатуйте їх за допомогою формул, щоб усі дані мали однаковий вигляд.

#6. Стандартизація процесу

Потрібно розробити стандартні операційні процедури (СОП), яких має дотримуватися ваша команда під час очищення даних. СОП має містити:

- Частоту збору вихідних даних

- Відповідальну особу за зберігання та обслуговування необроблених даних

- Частоту очищення

- Відповідальну особу за зберігання та обслуговування очищених даних

Нижче представлені популярні інструменти, які допоможуть вам у ваших аналітичних проєктах:

WinPure

WinPure – це надійне рішення, яке допоможе вам швидко та точно очищати дані. Цей інструмент пропонує функції очищення даних для компаній будь-якого розміру.

Програмне забезпечення використовує функцію профілювання даних для перевірки типів, форматів, цілісності та цінності даних. Його потужний механізм зіставлення даних вибирає ідеальні збіги з мінімальною кількістю помилок.

WinPure також пропонує візуалізацію даних, групові збіги та незбіги.

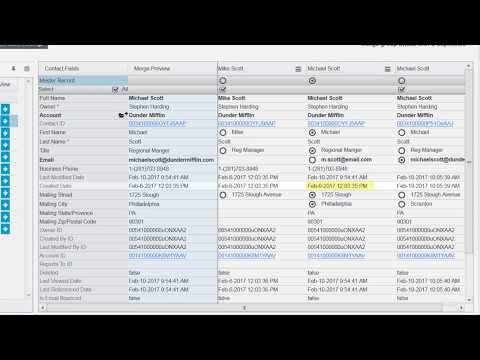

Інструмент може об’єднувати повторювані записи, зберігаючи всі актуальні значення. Також можна налаштувати правила вибору основного запису та миттєво видалити всі зайві записи.

OpenRefine

OpenRefine – це безкоштовний інструмент з відкритим вихідним кодом, який допомагає перетворювати неякісні дані в чистий формат. Він використовує фасети для очищення великих наборів даних і працює з фільтрованими представленнями даних.

Інструмент може об’єднувати подібні значення, щоб усунути невідповідності. Він пропонує можливості порівняння наборів даних із зовнішніми базами. Також ви можете повернутися до старішої версії даних, якщо це потрібно.

Користувачі можуть відтворити історію операцій у новій версії. OpenRefine очищає дані на вашому комп’ютері, тому немає потреби передавати їх у хмару.

Trifacta Designer Cloud

Trifacta Designer Cloud спрощує процес очищення даних. Інструмент використовує новий підхід до підготовки даних, щоб організації могли отримати максимальну вигоду.

Зручний інтерфейс дозволяє користувачам без технічних знань очищати дані для аналізу. Компанії можуть використовувати інтелектуальні пропозиції Trifacta Designer Cloud на основі машинного навчання, скорочуючи час на обробку даних та кількість помилок.

Cloudingo

Cloudingo призначений для користувачів Salesforce. Він дозволяє керувати даними клієнтів, використовуючи дедуплікацію, імпорт та міграцію.

Ви можете контролювати об’єднання записів за допомогою фільтрів і правил, а також стандартизувати дані. Видаліть непотрібні та неактивні дані, оновіть відсутні дані та забезпечте точність поштових адрес.

Cloudingo дозволяє запланувати автоматичне видалення дублікатів даних. Ви також можете порівнювати дані Salesforce з інформацією в електронній таблиці.

ZoomInfo

ZoomInfo – це рішення для очищення даних, яке підвищує ефективність вашої команди. Програмне забезпечення надає дані без дублювання в CRM та інших системах компанії.

ZoomInfo спрощує керування якістю даних, видаляючи дублікати. Він очищає дані за лічені хвилини за допомогою автоматичної дедуплікації, зіставлення та нормалізації.

Користувачі можуть налаштовувати критерії відповідності та об’єднані результати, створюючи економічно ефективну систему зберігання даних.

Підсумок

Якість вхідних даних є критично важливою для всіх аналітичних проєктів, особливо тих, що використовують машинне навчання та штучний інтелект. Якщо дані неякісні, то і результати цих проєктів будуть ненадійними.

Тому ваша організація має прийняти перевірені стратегії очищення даних та запровадити їх як стандартні операційні процедури. Це покращить якість вхідних даних.

Якщо ви зайняті проєктами, маркетингом та продажами, доцільно довірити частину очищення даних фахівцям. Експертами можуть бути будь-які з вищезазначених інструментів.

Можливо, вас також зацікавить схема процесу, яка допоможе реалізувати стратегії очищення даних.