У сучасному світі, де обсяги цифрової інформації зростають експоненціально, ми стикаємося з терабайтами та петабайтами даних. Виникає важливе питання: як ми можемо ефективно використовувати цю інформацію, перетворюючи її на корисні знання для покращення наших послуг?

Для будь-якої організації, що прагне виявляти знання, якісні, актуальні та зрозумілі дані є безцінними. Саме тому компанії застосовують різноманітні методи аналітики для отримання цих даних.

Але з чого починається цей процес? Відправною точкою є обробка даних.

Що таке Data Wrangling?

Обробка даних, або data wrangling, являє собою процес очищення, структурування та трансформації необроблених даних у формати, які полегшують їх аналіз. Це часто включає роботу з “брудними” та складними наборами даних, які не підходять для безпосереднього використання. Основна мета обробки даних – перетворити необроблену інформацію на чітку, оптимізовану та готову до використання.

Основні задачі обробки даних:

- Інтеграція різних наборів даних в єдиний аналітичний масив.

- Аналіз пропусків і відсутніх значень.

- Видалення викидів та аномальних даних.

- Уніфікація вхідних даних.

З огляду на величезні обсяги інформації, які зазвичай використовуються, процеси обробки даних потребують автоматизації, щоб забезпечити точність та високу якість результатів.

Мета Обробки Даних

Окрім підготовки даних для аналізу, основними цілями обробки даних є:

- Створення достовірної та нової інформації на основі неструктурованих даних для прийняття обґрунтованих бізнес-рішень.

- Стандартизація даних у формат, що підходить для систем обробки великих даних.

- Зменшення витрат часу аналітиків на підготовку моделей, завдяки представленню впорядкованих даних.

- Забезпечення послідовності, повноти, зручності використання та безпеки для всіх даних, що споживаються або зберігаються у сховищах.

Основні Підходи до Обробки Даних

Пошук

Перш ніж розпочати обробку, фахівці з даних повинні ретельно вивчити структуру даних, включаючи їх розмір, тип записів, формат кодування та інші характеристики.

Структурування

На цьому етапі дані організуються у формат, зручний для подальшого використання. Необхідно оптимізувати структуру наборів даних, враховуючи кількість стовпців, рядків та інші атрибути для спрощення аналізу.

Очищення

Структуровані набори даних потребують очищення від внутрішніх помилок та інших факторів, що можуть спотворити результати. Це включає видалення дублікатів, порожніх значень, викидів, стандартизацію вхідних даних та перейменування незрозумілих атрибутів.

Збагачення

Після очищення та структурування необхідно оцінити корисність даних. Для досягнення бажаної якості дані можуть доповнюватися значеннями з інших наборів.

Перевірка

Процес перевірки – це ітеративний процес, що виявляє якість даних, їх послідовність, зручність використання та безпеку. Цей етап підтверджує, що всі трансформації виконано та дані готові до аналізу і моделювання.

Представлення

На заключному етапі оброблені дані надаються для використання в аналітичних процесах. Також надається документація про етапи обробки та метадані.

Інструменти для Обробки Даних

Існує ряд інструментів, що допомагають в обробці даних. Ось декілька з них:

Talend

Talend – це уніфікована платформа управління даними, що забезпечує надійність та якість даних. Вона включає інтеграцію даних, застосунків та управління цілісністю даних. Обробка даних в Talend здійснюється за допомогою інтуїтивно зрозумілого інтерфейсу, що дозволяє проводити профілювання, очищення та документування даних.

Talend обробляє кожен етап життєвого циклу даних, забезпечуючи доступність, зручність використання, безпеку та цілісність бізнес-даних. Платформа також дозволяє інтегрувати дані з різних джерел, включаючи бази даних, хмарні сховища та API.

Основні Особливості Talend:

- Універсальна інтеграція даних: Збір даних з різноманітних джерел, хмарних або локальних середовищ.

- Гнучкість: Можливість створювати конвеєри даних, що можуть запускатися будь-де.

- Якість даних: Автоматичне очищення даних за допомогою машинного навчання.

- Інтеграція застосунків та API: Обмін даними через зручні API для платформ SaaS, JSON, AVRO та B2B.

R

R – це потужна мова програмування для статистичного аналізу та графіки, що використовується в наукових та бізнес-додатках. R – це одночасно мова програмування та середовище для маніпулювання, моделювання та візуалізації даних. R надає широкий спектр статистичних, кластеризаційних, аналітичних та графічних інструментів для обробки даних.

Основні Особливості R:

- Багатий набір пакетів: Понад 10 000 пакетів та розширень для обробки та аналізу даних.

- Висока продуктивність: Виконання складних операцій з даними за лічені секунди.

- Кросплатформна підтримка: Можливість працювати на різних операційних системах, сумісність з іншими мовами.

Trifacta

Trifacta – це інтерактивне хмарне середовище для профілювання даних, що використовує моделі машинного навчання та аналітики. Інструмент допомагає користувачам очищати дані від дублікатів, заповнювати порожні клітинки та трансформувати дані для аналізу. Trifacta надає візуалізовані профілі даних, що є зрозумілими для фахівців з різним рівнем технічної підготовки.

Основні Особливості Trifacta:

- Інтеграція з хмарою: Підтримка робочих навантажень підготовки в будь-якому хмарному або гібридному середовищі.

- Методи стандартизації: Різноманітні механізми стандартизації даних.

- Простий робочий процес: Організація завдань підготовки даних у вигляді потоків, що зменшує час на їх виконання.

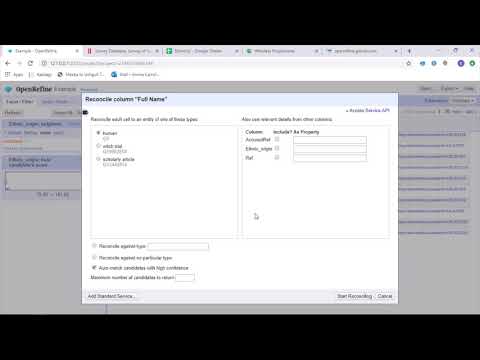

OpenRefine

OpenRefine – це інструмент з відкритим кодом для обробки “брудних” даних. Він дозволяє досліджувати набори даних, застосовувати складні трансформації для представлення даних у потрібному форматі. OpenRefine використовує фільтри та розділи для обробки даних, а також вбудовану мову General Refine Expression Language для аналізу та вилучення об’єктів.

Дані в OpenRefine зберігаються у вигляді проектів, які можна імпортувати з різних джерел, включаючи комп’ютерні файли, веб-URL-адреси та бази даних.

Основні Особливості OpenRefine:

- Кросплатформний інструмент: Працює на Windows, Mac та Linux.

- Багатий набір API: Підтримка різноманітних API для взаємодії з даними.

Datameer

Datameer – це інструмент перетворення даних SaaS, розроблений для спрощення обміну та інтеграції даних через процеси розробки програмного забезпечення. Datameer дозволяє видобувати, трансформувати та завантажувати дані у хмарні сховища, такі як Snowflake. Інструмент добре працює зі стандартними форматами даних, включаючи CSV та JSON, дозволяючи імпортувати дані для подальшої агрегації.

Datameer пропонує широкий спектр функцій, включаючи документування даних, профілювання та виявлення. Також забезпечується візуальний профіль даних, який дозволяє користувачам відстежувати недійсні, відсутні або несхожі значення.

Datameer пропонує гібридний інтерфейс, що поєднує роботу з кодом і без коду, що дозволяє широкому колу користувачів створювати складні конвеєри ETL.

Основні Особливості Datameer:

- Багатокористувацькі середовища: Підтримка різних рівнів технічної підготовки користувачів.

- Спільні робочі області: Можливість командної роботи над проектами.

- Документація даних: Підтримка системної та користувацької документації.

Заключні слова

Аналіз даних – це складний процес, що вимагає належної організації даних. Інструменти обробки даних допомагають перетворювати великі обсяги необроблених даних у формати, придатні для аналізу. Вибір інструменту залежить від вимог та потреб конкретного проєкту. Опанування інструментами обробки даних є ключовим для досягнення успіху в аналітиці.

Вам також може бути цікаво:

Найкращі інструменти CSV для перетворення, форматування та перевірки.