Для людей, які не знайомі з кодуванням, створити веб-скребок може бути складно. На щастя, програмне забезпечення для веб-скрейпінгу доступне як для програмістів, так і для непрограмістів. Програмне забезпечення для веб-скрейпінгу — це спеціально розроблене програмне забезпечення для отримання відповідних даних з веб-сайтів. Ці інструменти корисні для всіх, хто хоче якимось чином отримати дані з Інтернету. Ця інформація записується в локальний файл на комп’ютері або в базу даних. Це техніка автономного збору даних для Інтернету. Ми представляємо список з 31 найкращих безкоштовних інструментів для веб-скрейпінгу.

31 найкращий інструмент для веб-скрейпінгу

Вибраний список найкращих інструментів для веб-скрейпінгу можна знайти тут. Цей список містить як комерційні інструменти, так і інструменти з відкритим кодом, а також посилання на відповідні веб-сайти.

1. Перехитрити

Outwit — це надбудова Firefox, яку легко встановити з магазину доповнень Firefox.

- За допомогою цього інструмента для скріплення даних можна легко збирати контакти з Інтернету та електронної пошти.

- Залежно від ваших вимог у вас буде три варіанти придбання цього продукту.

- професіонал

-

Експерт і

-

Доступні видання Enterprise.

- Для отримання точних даних із сайтів за допомогою центру Outwit не потрібні знання програмування.

- Ви можете почати переглядати сотні веб-сторінок одним натисканням кнопки дослідження.

2. PareseHub

ParseHub — ще один з найкращих безкоштовних інструментів для скрейпінгу.

- Перш ніж завантажувати дані, очистіть текст і HTML.

- Це так само просто, як вибрати дані, які ви хочете отримати, за допомогою нашого складного веб-скребка.

- Це один з найкращих інструментів для скрейпінгу даних, оскільки він дозволяє зберігати дані в будь-якому форматі для подальшого аналізу.

- Зручний графічний інтерфейс

- Цей інструмент для скрейпінгу в Інтернеті дозволяє автоматично збирати та зберігати дані на серверах.

3. Апіфікувати

Apify — це ще один з найкращих інструментів веб-скрейпінгу та автоматизації, який дозволяє створювати API для будь-якого веб-сайту з вбудованими проксі-серверами для житлових будинків і центрів обробки даних, які полегшують вилучення даних.

- Apify піклується про інфраструктуру та виставлення рахунків, дозволяючи розробникам заробляти пасивні гроші, розробляючи інструменти для інших.

- Деякі з доступних роз’ємів – Zapier, Integromat, Keboola та Airbyte.

- Apify Store має готові рішення для скрейпінгу для популярних веб-сайтів, таких як Instagram, Facebook, Twitter і Google Maps.

- JSON, XML, CSV, HTML і Excel – це структуровані форми, які можна завантажити.

- HTTPS, націлювання на геолокацію, розумна ротація IP-адресів і проксі-сервери Google SERP – це всі функції Apify Proxy.

- Безкоштовна 30-денна пробна версія проксі з кредитом на платформу 5 доларів США.

4. Scrapestack

Scrapestack використовується понад 2000 фірмами, і вони покладаються на цей унікальний API, який працює на основі apilayer. Це один з найкращих безкоштовних інструментів для веб-скрейпінгу.

- Використовує всесвітній пул IP-адрес із 35 мільйонів центрів обробки даних.

- Дозволяє виконувати багато запитів API одночасно.

- Підтримуються як розшифрування CAPTCHA, так і рендеринг JavaScript.

- Доступні як безкоштовні, так і платні варіанти.

- Scrapestack — це онлайновий Scrape API REST, який працює в режимі реального часу.

- API scrapestack дає змогу очищати веб-сторінки за мілісекунди, використовуючи мільйони IP-адрес проксі-сервера, браузери та CAPTCHA.

- Запити веб-скрейпінгу можуть надсилатися з більш ніж 100 різних місць по всьому світу.

5. FMMiner

Для Windows і Mac OS FMiner — це популярна програма для онлайн-скрейпінгу, вилучення даних, сканування екрана, макросів і веб-підтримка.

- Дані можуть бути зібрані з складних для сканування динамічних веб-сайтів Web 2.0.

- Дозволяє створити проект вилучення даних за допомогою візуального редактора, який простий у використанні.

- Використовує комбінацію структур посилань, спадних меню та відповідності шаблону URL-адреси, щоб ви могли переглядати веб-сторінки.

- Ви можете використовувати сторонні автоматичні служби декаптча або вводити вручну, щоб націлити захист CAPTCHA на веб-сайт.

6. Послідовність

Sequentum — це надійний інструмент для отримання достовірних даних в Інтернеті. Це ще один з найкращих безкоштовних інструментів для веб-скрейпінгу.

- У порівнянні з альтернативними рішеннями, вилучення онлайн-даних стає швидшим.

- За допомогою цієї функції можна переходити між кількома платформами.

- Це один із найпотужніших веб-скребків для розвитку вашої компанії. Він містить прості функції, включаючи візуальний редактор «наведи і клацни».

- Спеціальний веб-API допоможе вам розробляти веб-програми, дозволяючи виконувати веб-дані прямо зі свого веб-сайту.

7. Агентство

Agenty — це програма для очищення даних, вилучення тексту та розпізнавання тексту, яка використовує автоматизацію роботизованих процесів.

- Ця програма дозволяє переназначити всі ваші оброблені дані для аналітичних цілей.

- Ви можете створити агента лише кількома клацаннями миші.

- Після виконання завдання ви отримаєте повідомлення електронною поштою.

- Це дозволяє підключатися до Dropbox і використовувати безпечний FTP.

- Усі журнали активності для всіх випадків доступні для перегляду.

- Допомагає вам покращити успіх вашої компанії.

- Дозволяє легко впроваджувати бізнес-правила та користувацьку логіку.

8. Import.io

Імпортуючи дані з певної веб-сторінки та експортуючи їх у CSV, програма для веб-скрейпінгу import.io допомагає вам формувати набори даних. Це також один з найкращих інструментів для веб-скрейпінгу. Нижче наведено особливості цього інструменту.

- Веб-форми/логіни прості у використанні.

- Це одне з найкращих рішень зі скрейпінгу даних для використання API та веб-хуків для інтеграції даних у програми.

- Ви можете отримати уявлення за допомогою звітів, діаграм і візуалізацій.

- Вилучення даних слід планувати заздалегідь.

- Хмара Import.io дозволяє зберігати дані та отримувати доступ до них.

- Взаємодія з Інтернетом і робочими процесами можна автоматизувати.

9. Webz.io

Webz.io дозволяє сканувати сотні веб-сайтів і одразу мати доступ до структурованих даних у реальному часі. Це також один з найкращих безкоштовних інструментів для веб-скрейпінгу.

Ви можете придбати організовані, машиночитані набори даних у форматах JSON та XML.

- Це дає вам доступ до історичних каналів, які охоплюють дані протягом десяти років.

- Дозволяє мати доступ до великої бази даних каналів даних без необхідності сплачувати будь-які додаткові витрати.

- Ви можете використовувати розширений фільтр для детального аналізу та передачі даних.

10. Скребка

Scrape Owl — це проста у використанні та економічна платформа для веб-скребування.

- Основною метою Scrape Owl є очищення будь-яких типів даних, включаючи електронну комерцію, дошки вакансій та списки нерухомості.

- Перш ніж витягти матеріал, ви можете запустити власний JavaScript.

- Ви можете використовувати локації, щоб обійти місцеві обмеження та отримати доступ до місцевого вмісту.

- Забезпечує надійну функцію очікування.

- Підтримується повносторінкове відтворення JavaScript.

- Цю програму можна використовувати безпосередньо на аркуші Google.

- Пропонує безкоштовну пробну версію 1000 кредитів, щоб випробувати послугу перед покупкою будь-якого членства. Немає необхідності використовувати кредитну картку.

11. Скрібка

Scrapingbee — це API для веб-скрейпінгу, який керує налаштуваннями проксі-сервера та безголовними браузерами.

- Він може виконувати Javascript на сторінках і обертати проксі для кожного запиту, тому ви можете прочитати необроблений HTML, не потрапляючи в чорний список.

- Також доступний другий API для вилучення результатів пошуку Google.

- Підтримується рендеринг JavaScript.

- Він має функцію автоматичної ротації проксі.

- Цю програму можна використовувати безпосередньо в Google Таблицях.

- Для використання програми потрібен веб-браузер Chrome.

- Він ідеально підходить для скребку Amazon.

- Це дозволяє очищати результати Google.

12. Яскраві дані

Bright Data — це провідна світова платформа даних онлайн, яка пропонує економічне рішення для збору загальнодоступних веб-даних у масштабі, легкого перетворення неструктурованих даних у структуровані дані та забезпечення чудового досвіду клієнтів, будучи повністю прозорим і відповідним вимогам.

- Це найбільш адаптивний, оскільки має готові рішення, його можна розширювати та регулювати.

- Колектор даних наступного покоління Bright Data забезпечує автоматизований та персоналізований потік даних на одній інформаційній панелі, незалежно від розміру колекції.

- Він відкритий 24 години на добу, сім днів на тиждень і пропонує допомогу клієнтам.

- Від тенденцій електронної комерції та даних соціальних мереж до розвідки конкурентів і дослідження ринку — набори даних адаптуються до потреб вашого бізнесу.

- Ви можете зосередитися на своєму основному бізнесі, автоматизувавши доступ до надійних даних у своїй галузі.

- Він є найефективнішим, оскільки використовує рішення без коду та використовує менше ресурсів.

- Найнадійніший, із найкращою якістю даних, більшим часом безперебійної роботи, швидшими даними та кращим обслуговуванням клієнтів.

13. API скрепера

Ви можете використовувати інструмент Scraper API для обробки проксі, браузерів і CAPTCHA.

- Інструмент забезпечує неперевершену швидкість і надійність, що дозволяє створювати масштабовані веб-скребки.

- Ви можете отримати HTML з будь-якої веб-сторінки за допомогою одного виклику API.

- Це просто налаштувати, оскільки все, що вам потрібно зробити, це надіслати запит GET із вашим ключем API та URL-адресою на кінцеву точку API.

- Дозволяє легше відображати JavaScript.

- Він дозволяє налаштувати тип запиту та заголовки для кожного запиту.

- Обертання проксі з географічним розташуванням

14. Dexi Intelligent

Dexi intelligent — це онлайн-додаток для скрейпінгу, який дозволяє перетворити будь-яку кількість веб-даних у швидку комерційну цінність.

- Цей онлайн-інструмент для скребкування дозволяє заощадити гроші та час для вашої компанії.

- Він покращив продуктивність, точність і якість.

- Це забезпечує найшвидше та найефективніше вилучення даних.

- Він має широкомасштабну систему збору знань.

15. Diffbot

Diffbot дозволяє швидко отримувати різноманітні важливі факти з Інтернету.

- За допомогою екстракторів AI ви зможете отримувати точні структуровані дані з будь-якої URL-адреси.

- З вас не стягуватиметься плата за трудомісткий перегляд веб-сайтів або запити вручну.

- Щоб побудувати повне і точне зображення кожного об’єкта, багато джерел даних об’єднуються.

- Ви можете витягувати структуровані дані з будь-якої URL-адреси за допомогою AI Extractors.

- За допомогою Crawlbot ви можете розширити вилучення до десятків тисяч доменів.

- Функція «Графік знань» надає в Інтернет точні, повні та глибокі дані, які необхідні BI для надання значущої інформації.

16. Стрімер даних

Data Streamer — це технологія, яка дозволяє отримувати матеріали соціальних мереж з усього Інтернету.

- Це один з найбільших онлайн-скребків, який використовує обробку природної мови для отримання важливих метаданих.

-

Kibana та Elasticsearch використовуються для забезпечення інтегрованого повнотекстового пошуку.

- На основі алгоритмів пошуку інформації, інтегрованого видалення шаблонів і вилучення вмісту.

- Побудований на основі відмовостійкої інфраструктури для забезпечення високої доступності інформації.

17. Мозенда

Ви можете витягувати текст, фотографії та PDF-матеріали з веб-сторінок за допомогою Mozenda.

- Ви можете використовувати інструмент Bl або базу даних на ваш вибір для збору та публікації даних в Інтернеті.

- Це один з найкращих онлайн-інструментів для впорядкування та форматування файлів даних для публікації.

- Завдяки інтерфейсу «наведи і клацни», ви можете створити агенти веб-скрейпінгу за лічені хвилини.

- Щоб збирати веб-дані в режимі реального часу, скористайтеся функціями Job Sequencer і Request Blocking.

- Управління обліковими записами та обслуговування клієнтів є одними з найкращих у галузі.

18. Розширення Data Miner Chrome

За допомогою плагіна для веб-переглядача Data Miner спрощуються веб-скрейпінгу та збирання даних.

- Він має можливість сканування кількох сторінок, а також динамічне вилучення даних.

- Вибір даних може здійснюватися різними способами.

- Він перевіряє інформацію, яка була вирізана.

- Зроблені дані можна зберегти як файл CSV.

- Локальне сховище використовується для зберігання зашифрованих даних.

- Доповнення Chrome Web Scraper витягує дані з динамічних сайтів.

- it Карти сайту можна імпортувати та експортувати.

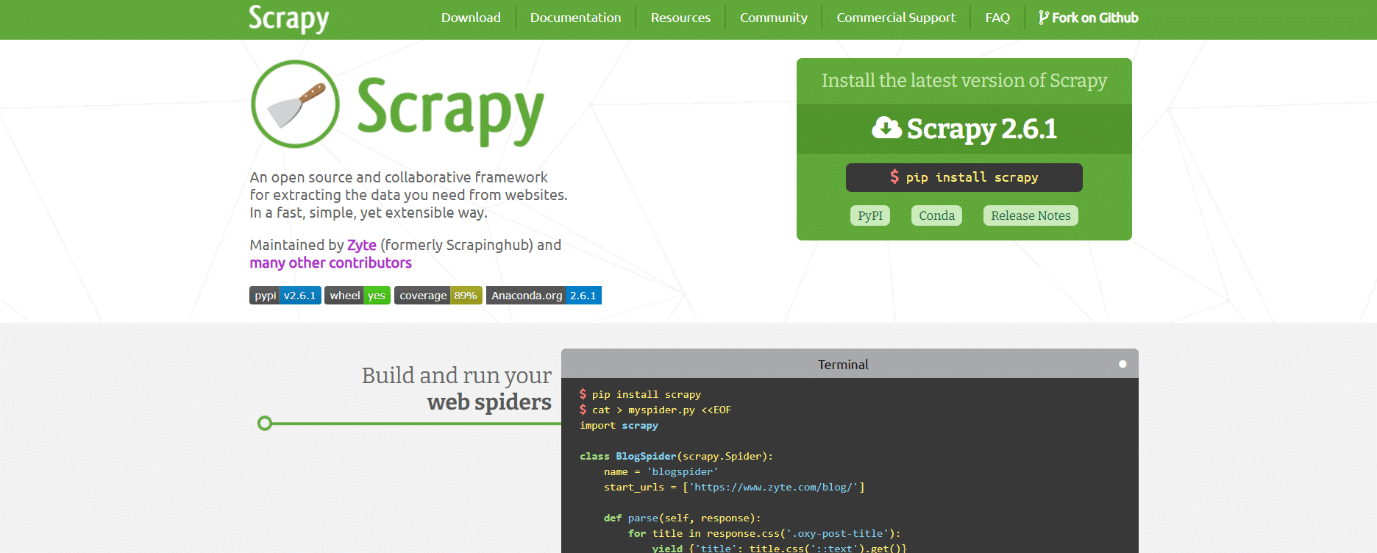

19. Скрепі

Scrapy також є одним із найкращих інструментів для веб-скрейпінгу. Це фреймворк онлайн-скрейпінгу на основі Python з відкритим кодом для створення веб-скрейперів.

- Він надає вам усі інструменти, які вам знадобляться для швидкого вилучення даних із веб-сайтів, їх аналізу та збереження у структурі та форматі на ваш вибір.

- Цей інструмент для шифрування даних необхідний, якщо у вас є великий проект зі скрейпінгу даних і ви хочете зробити його максимально ефективним, зберігаючи при цьому велику гнучкість.

- Дані можна експортувати як JSON, CSV або XML.

- Підтримуються Linux, Mac OS X і Windows.

- Він розроблений на основі технології асинхронної мережі Twisted, яка є однією з її ключових особливостей.

- Scrapy відрізняється простотою використання, великою документацією та активною спільнотою.

20. Хмара ScrapeHero

ScrapeHero взяв свої багаторічні знання про сканування веб-сторінок і перетворив його на економічні та прості у використанні попередньо створені сканери та API для вилучення даних із таких сайтів, як Amazon, Google, Walmart та інших.

- Сканер ScrapeHero Cloud включає проксі, що автоматично обертається, і можливість одночасного запуску багатьох сканерів.

- Щоб використовувати ScrapeHero Cloud, вам не потрібно завантажувати або вчитися використовувати будь-які інструменти чи програмне забезпечення для зняття даних.

- Сканер ScrapeHero Cloud дозволяє миттєво збирати дані та експортувати їх у формати JSON, CSV або Excel.

- Клієнти безкоштовного та спрощеного плану ScrapeHero Cloud отримують допомогу електронною поштою, тоді як усі інші плани отримують пріоритетну послугу.

- Сканер ScrapeHero Cloud також може бути налаштований відповідно до конкретних вимог клієнтів.

- Це веб-скребок на основі браузера, який працює з будь-яким веб-браузером.

- Вам не потрібні знання програмування чи розробка скрепера; це так само просто, як клацання, копіювання та вставлення!

21. Скребок даних

Data Scraper — це безкоштовна онлайн-програма для скрейпінгу, яка витягує дані з однієї веб-сторінки та зберігає їх у файлі CSV або XSL.

- Це розширення для браузера, яке перетворює дані в акуратний табличний формат.

- Для встановлення плагіна необхідно використовувати браузер Google Chrome.

- Ви можете скребти 500 сторінок щомісяця за допомогою безкоштовної версії; але якщо ви хочете отримати більше сторінок, ви повинні перейти до одного з дорогих планів.

22. Візуальний веб-рипер

Visual Web Ripper — це інструмент автоматичного очищення даних для веб-сайтів.

- Структури даних збираються з веб-сайтів або результатів пошуку за допомогою цього інструменту.

- Ви можете експортувати дані у файли CSV, XML та Excel, і він має зручний інтерфейс.

- Він також може збирати дані з динамічних веб-сайтів, наприклад тих, які використовують AJAX.

- Вам просто потрібно налаштувати кілька шаблонів, а веб-скребок впорається з іншим.

- Visual Web Ripper пропонує параметри планування і навіть надсилає вам електронний лист, якщо проект не вдається.

23. Осьминог

Octoparse — це зручна програма для перегляду веб-сторінок із візуальним інтерфейсом. Це один з найкращих безкоштовних інструментів для веб-скрейпінгу. Нижче наведено особливості цього інструменту.

- Його інтерфейс «наведи і клацни» полегшує вибір інформації, яку ви бажаєте отримати з веб-сайту. Octoparse може обробляти як статичні, так і динамічні веб-сторінки завдяки AJAX, JavaScript, файлам cookie та іншим можливостям.

- Тепер доступні передові хмарні сервіси, які дозволяють отримувати великі обсяги даних.

- Отриману інформацію можна зберегти як файли TXT, CSV, HTML або XLSX.

- Безкоштовна версія Octoparse дозволяє створити до 10 сканерів; однак платні плани членства включають такі функції, як API та велику кількість анонімних IP-проксі, що прискорить ваше вилучення та дозволить завантажувати великі обсяги даних у режимі реального часу.

24. Веб Харві

Візуальний веб-скрепер WebHarvey має вбудований браузер для запису даних з онлайн-сайтів. Це також один з найкращих інструментів для веб-скрейпінгу. Ось деякі особливості цього інструменту.

- Він пропонує інтерфейс «наведи й клацни», що спрощує вибір елементів.

- Перевага цього скрепера полягає в тому, що він не вимагає від вас писати код.

-

Для збереження даних можна використовувати файли CSV, JSON і XML.

- Його також можна зберегти в базі даних SQL. WebHarvey має багаторівневу функцію скрейпінгу категорій, яка може видаляти дані зі сторінок списку, дотримуючись кожного рівня з’єднань категорій.

- Регулярні вирази можна використовувати разом із інструментом для скрейпінгу в Інтернеті, що дає вам додаткову свободу.

- Ви можете налаштувати проксі-сервери, щоб приховати свою IP-адресу під час отримання даних із веб-сайтів, що дозволить вам зберегти певну конфіденційність.

25. PySpider

PySpider також є одним із найкращих безкоштовних інструментів для скрейпінгу, який є веб-сканером на основі Python. Нижче наведено кілька функцій цього інструменту.

- Він має розподілену архітектуру та підтримує сторінки Javascript.

- Таким чином, у вас може бути багато сканерів. PySpider може зберігати дані на будь-якому сервері, який ви виберете, включаючи MongoDB, MySQL, Redis та інші.

- Доступні такі черги повідомлень, як RabbitMQ, Beanstalk і Redis.

- Однією з переваг PySpider є його простий користувальницький інтерфейс, який дозволяє змінювати сценарії, відстежувати запущені дії та переглядати результати.

- Інформацію можна завантажити у форматах JSON та CSV.

- PySpider — це підбірка Інтернету, яку слід враховувати, якщо ви працюєте з інтерфейсом користувача на основі веб-сайту.

- Він також працює з веб-сайтами, які використовують багато AJAX.

26. Захоплення вмісту

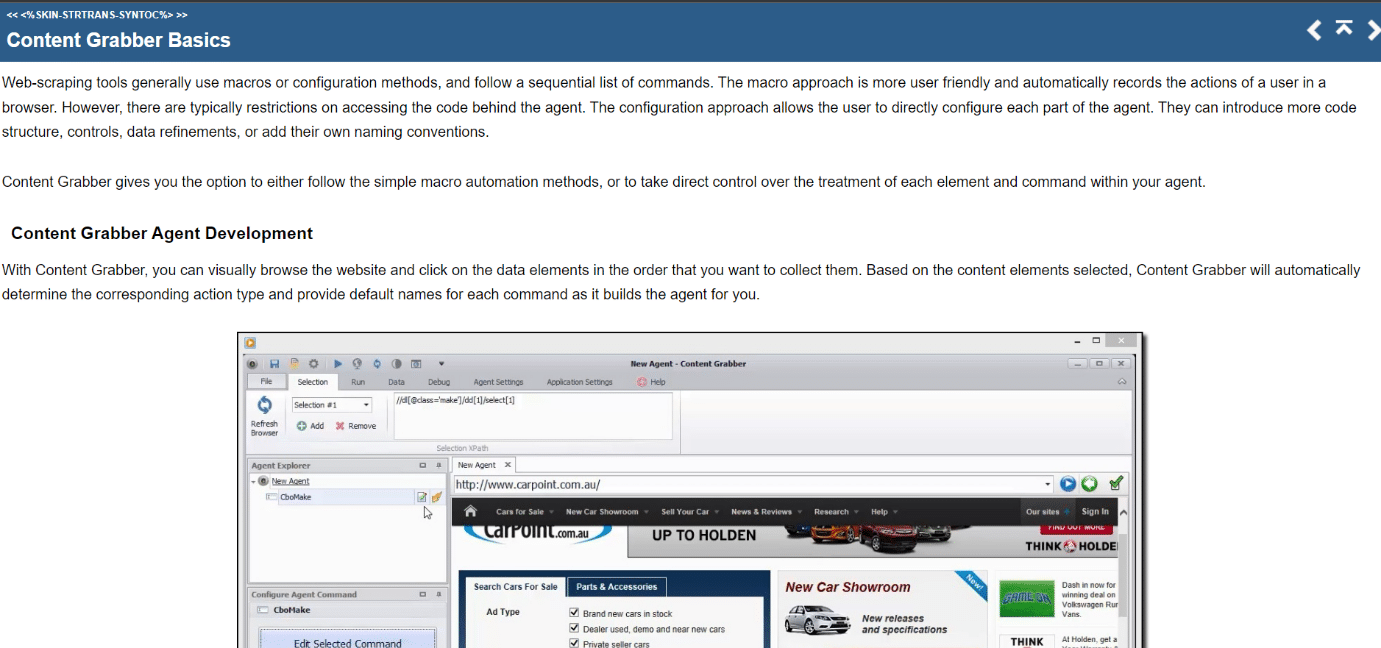

Content Grabber — це візуальний онлайн-інструмент для вибору елементів із простим у використанні інтерфейсом «наведи й клацни». Нижче наведено особливості цього інструменту.

- CSV, XLSX, JSON і PDF – це формати, в яких можна експортувати дані. Для використання цього інструменту потрібні середні навички програмування.

- Завдяки інтерфейсу користувача доступне розбиття на сторінки, безмежна прокрутка сторінок і спливаючі вікна.

- Він також має обробку AJAX/Javascript, рішення captcha, підтримку регулярних виразів і чергування IP-адресів (за допомогою Nohodo).

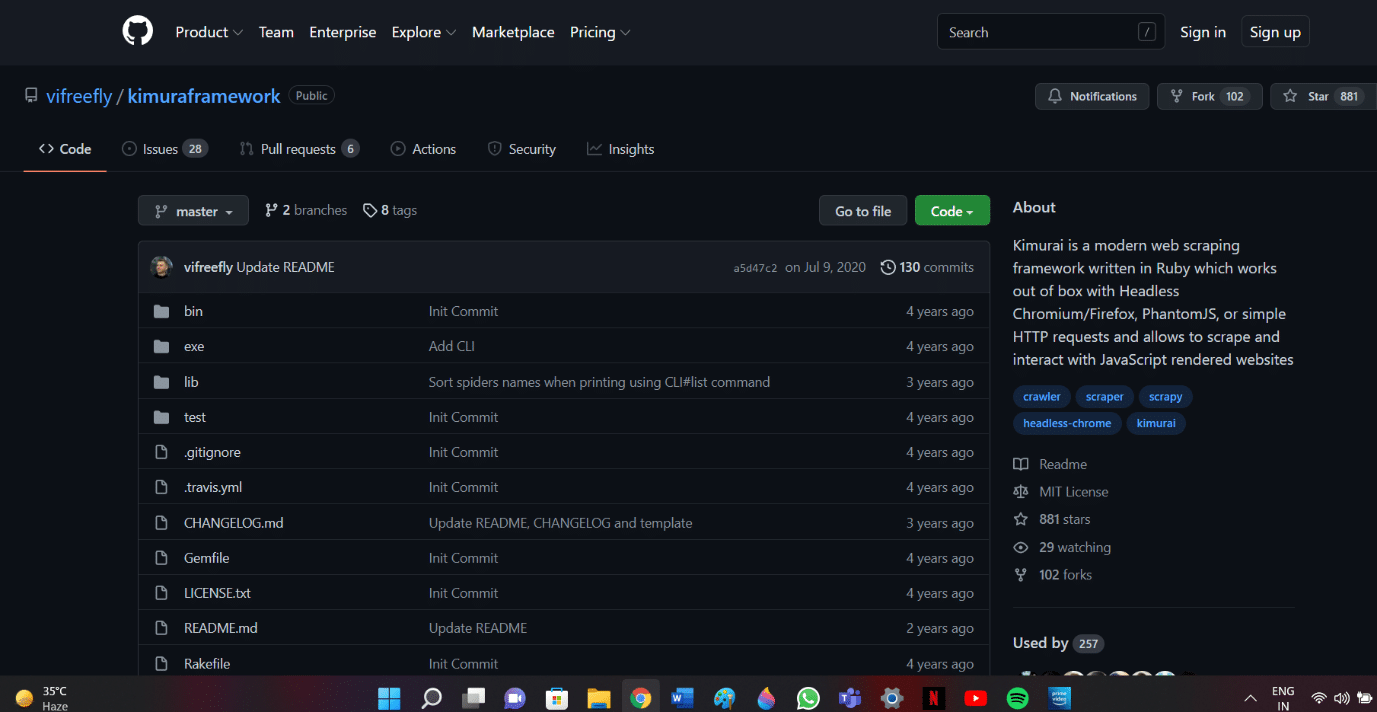

27. Кімурай

Kimurai — це фреймворк для веб-скрейпінгу Ruby для створення скребків і вилучення даних. Це також один з найкращих безкоштовних інструментів для веб-скрейпінгу. Ось деякі особливості цього інструменту.

- Це дає нам змогу очищати веб-сторінки, створені JavaScript, і взаємодіяти з ними прямо з коробки за допомогою Headless Chromium/Firefox, PhantomJS або базових запитів HTTP.

- Він має синтаксис, подібний до Scrapy, і настроювані параметри, включаючи встановлення затримки, чергування користувацьких агентів і заголовки за замовчуванням.

- Він також взаємодіє з веб-сторінками за допомогою системи тестування Capybara.

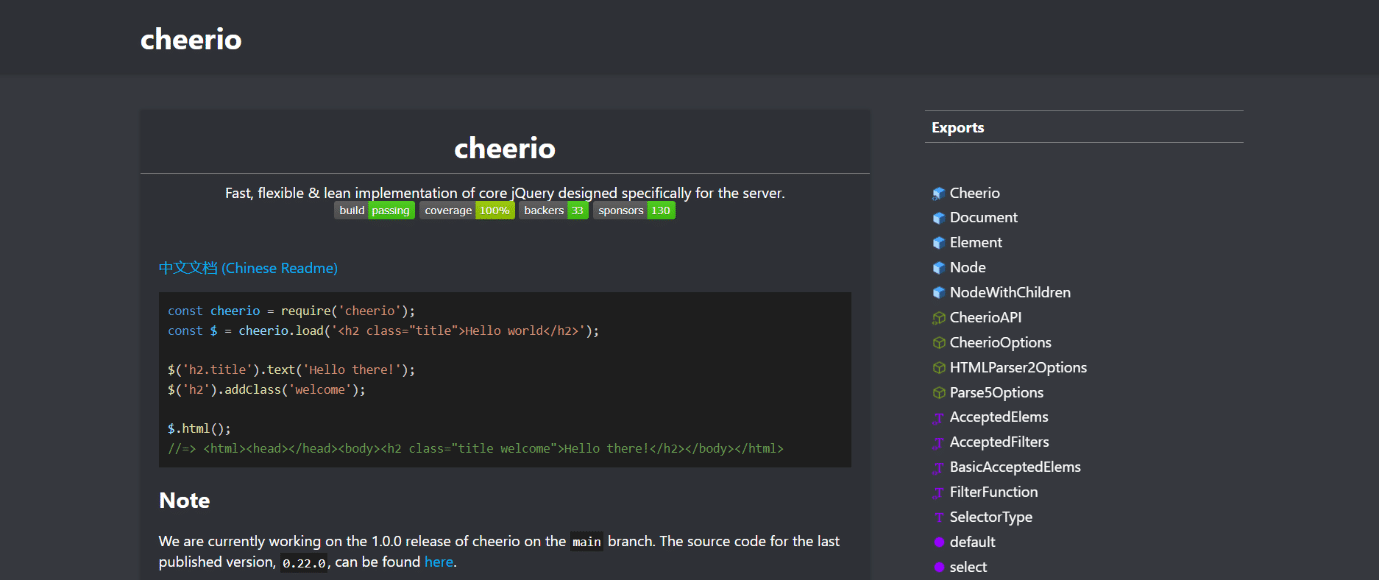

28. Cheerio

Cheerio — ще один з найкращих інструментів для веб-скрейпінгу. Це пакунок, який аналізує документи HTML і XML і дозволяє вам оперувати завантаженими даними за допомогою синтаксису jQuery. Нижче наведено особливості цього інструменту.

- Якщо ви розробляєте веб-скребок JavaScript, Cheerio API надає швидкий вибір для аналізу, зміни та відображення даних.

- Він не відтворює вихідні дані у веб-браузері, не застосовує CSS, не завантажує зовнішні ресурси та не запускає JavaScript.

- Якщо потрібна будь-яка з цих функцій, вам слід подивитися на PhantomJS або JSDom.

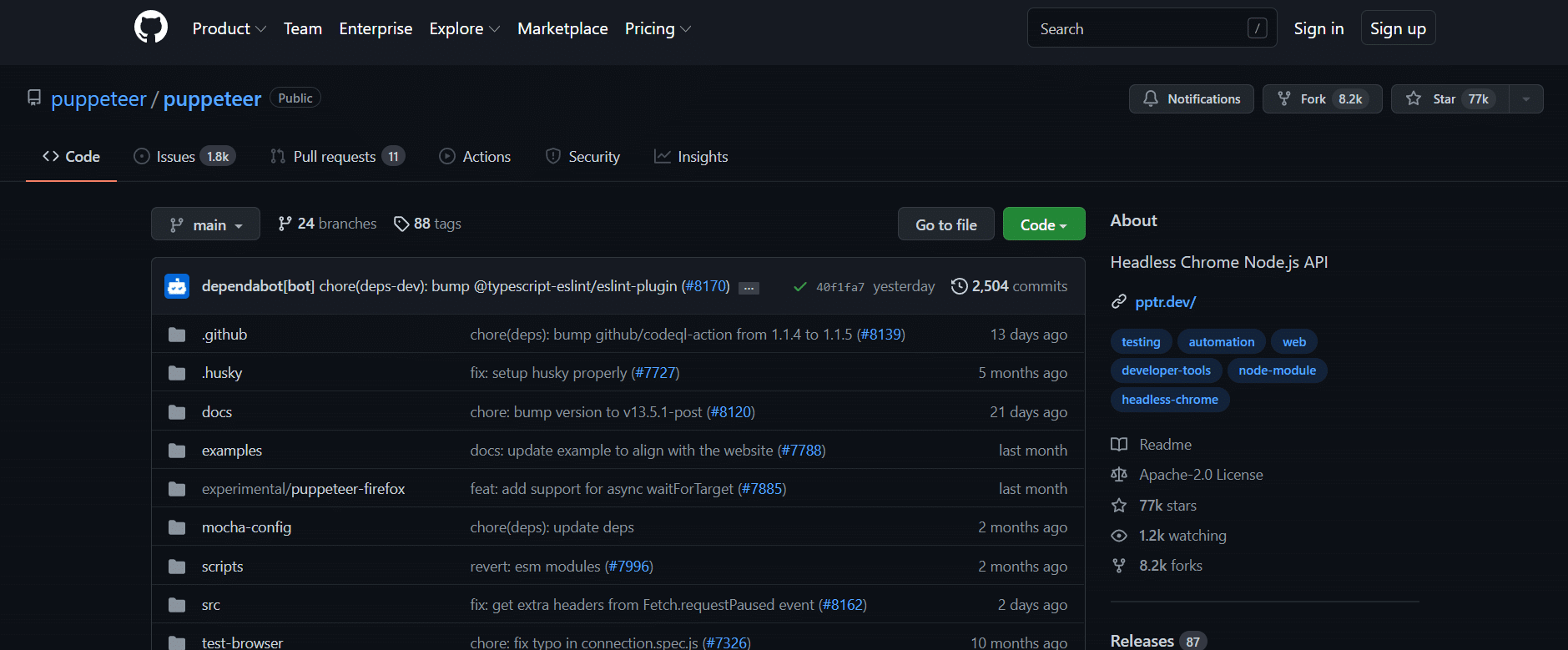

29. Лялькар

Puppeteer — це пакет Node, який дозволяє керувати безголовим браузером Google Chrome за допомогою потужного, але простого API. Нижче наведено кілька функцій цього інструменту.

- Він працює у фоновому режимі, виконуючи команди через API.

- Безголовий браузер — це браузер, який здатний надсилати та отримувати запити, але не має графічного інтерфейсу користувача.

- Puppeteer є правильним рішенням для цієї задачі, якщо інформація, яку ви шукаєте, генерується за допомогою комбінації даних API та коду Javascript.

- Ви можете імітувати досвід користувача, вводячи текст і клацаючи в тих же місцях, що й вони.

- Puppeteer також можна використовувати для створення скріншотів веб-сторінок, які відображаються за замовчуванням, коли відкривається веб-браузер.

30. Драматург

Playwright — бібліотека Microsoft Node, розроблена для автоматизації браузера. Це ще один з найкращих безкоштовних інструментів для веб-скрейпінгу. Ось деякі особливості цього інструменту.

- Він пропонує компетентну, надійну та швидку міжбраузерну веб-автоматизацію.

- Playwright мав на меті покращити автоматичне тестування інтерфейсу користувача, усунувши нестабільність, збільшивши швидкість виконання та надавши уявлення про те, як працює браузер.

- Це сучасна програма для автоматизації браузера, яка багато в чому порівнянна з Puppeteer і постачається з попередньо встановленими сумісними браузерами.

- Його головною перевагою є міжбраузерна сумісність, оскільки він може запускати Chromium, WebKit і Firefox.

- Playwright регулярно інтегрується з Docker, Azure, Travis CI і AppVeyor.

31. PJScrape

PJscrape — це онлайн-інструмент для скрейпінгу на основі Python, який використовує Javascript і JQuery. Нижче наведено особливості цього інструменту.

- Він розроблений для роботи з PhantomJS, тому ви можете очищати сайти з командного рядка в повністю відтвореному контексті з підтримкою Javascript, не потребуючи браузера.

- Це означає, що ви можете отримати доступ не тільки до DOM, але й до змінних і функцій Javascript, а також до вмісту, завантаженого AJAX.

- Функції скребка оцінюються в контексті всього браузера.

***

Сподіваємося, що цей посібник був корисним щодо найкращих інструментів для веб-скрейпінгу. Повідомте нам, який інструмент вам буде зручним. Продовжуйте відвідувати нашу сторінку, щоб отримати більше крутих порад і підказок, і залишайте свої коментарі нижче.