Для тих, хто не має досвіду в програмуванні, створення веб-скрепера може здаватися складним завданням. Однак, на щастя, існують програмні рішення для веб-скрейпінгу, які підходять як для розробників, так і для користувачів без навичок програмування. Ці спеціалізовані інструменти призначені для автоматизованого отримання даних з веб-сайтів. Вони є цінним ресурсом для будь-кого, хто потребує збору інформації з Інтернету. Отримані дані зазвичай зберігаються в локальному файлі на вашому комп’ютері або в базі даних. Цей процес являє собою автономний метод збору веб-інформації. Нижче ми пропонуємо перелік з 31 найкращого безкоштовного інструмента для веб-скрейпінгу.

31 Найкращий Інструмент для Веб-Скрейпінгу

Тут представлений відібраний перелік найкращих інструментів для веб-скрейпінгу. Цей список включає як комерційні продукти, так і інструменти з відкритим кодом, з посиланнями на відповідні веб-ресурси.

1. Outwit

Outwit – це розширення для Firefox, яке легко встановлюється з магазину доповнень Firefox.

- Цей інструмент дозволяє без особливих зусиль збирати контактну інформацію та електронні адреси з веб-сторінок.

- Пропонується три варіанти придбання продукту, залежно від ваших потреб:

- Професійний

- Експертний

- Корпоративний

- Інструмент Outwit дозволяє отримувати точні дані з веб-сайтів без необхідності володіння навичками програмування.

- Ви можете розпочати дослідження сотень веб-сторінок одним кліком.

2. ParseHub

ParseHub – це ще один ефективний безкоштовний інструмент для веб-скрейпінгу.

- Він дозволяє очищати текст та HTML перед завантаженням даних.

- Користувач може просто виділити необхідні дані для вилучення, використовуючи цей потужний скрепер.

- ParseHub є одним із найкращих інструментів для збору даних, оскільки дозволяє зберігати інформацію в будь-якому форматі для подальшого аналізу.

- Інструмент має інтуїтивно зрозумілий графічний інтерфейс.

- ParseHub дає можливість автоматизувати збір та зберігання даних на серверах.

3. Apify

Apify – це передовий інструмент для веб-скрейпінгу та автоматизації, який дозволяє створювати API для будь-якого веб-сайту. Він включає вбудовані проксі-сервери для домашніх мереж та центрів обробки даних, що спрощує процес вилучення даних.

- Apify бере на себе питання інфраструктури та оплати, дозволяючи розробникам отримувати пасивний дохід, створюючи інструменти для інших.

- Інтеграція з такими сервісами як Zapier, Integromat, Keboola та Airbyte є доступною.

- Apify Store пропонує готові рішення для скрейпінгу популярних веб-сайтів, таких як Instagram, Facebook, Twitter та Google Maps.

- Дані можуть бути завантажені у структурованих форматах JSON, XML, CSV, HTML та Excel.

- Apify Proxy підтримує HTTPS, таргетинг на геолокацію, розумну ротацію IP-адрес та проксі-сервери Google SERP.

- Надається безкоштовна 30-денна пробна версія проксі з кредитом на платформу у розмірі 5 доларів США.

4. Scrapestack

Scrapestack є надійним API, який використовується понад 2000 компаній та працює на основі apilayer. Це один з провідних безкоштовних інструментів для веб-скрейпінгу.

- Він використовує глобальний пул IP-адрес із 35 мільйонами варіантів від центрів обробки даних.

- Дозволяє обробляти численні API-запити одночасно.

- Підтримує розшифровку CAPTCHA та рендеринг JavaScript.

- Пропонуються як безкоштовні, так і платні варіанти.

- Scrapestack – це онлайн-сервіс Scrape API REST, який працює в режимі реального часу.

- API scrapestack дозволяє очищати веб-сторінки за мілісекунди, використовуючи мільйони IP-адрес проксі-сервера, браузери та CAPTCHA.

- Запити веб-скрейпінгу можна надсилати з понад 100 різних локацій по всьому світу.

5. FMiner

FMiner є популярним додатком для онлайн-скрейпінгу, вилучення даних, сканування екрану, створення макросів та веб-підтримки для Windows і Mac OS.

- Він дозволяє збирати дані зі складних для сканування динамічних веб-сайтів Web 2.0.

- Користувач може створити проєкт вилучення даних, використовуючи простий візуальний редактор.

- FMiner використовує комбінацію структури посилань, спадних меню та відповідності шаблону URL-адреси для навігації веб-сторінками.

- Для обходу CAPTCHA можна використовувати сторонні автоматичні сервіси декаптча або ручне введення.

6. Sequentum

Sequentum – це надійний інструмент для отримання точних даних з інтернету. Це ще один ефективний безкоштовний інструмент для веб-скрейпінгу.

- Вилучення онлайн-даних виконується швидше порівняно з іншими рішеннями.

- Інструмент дозволяє переходити між різними платформами.

- Sequentum є одним із потужних веб-скреперів для розвитку вашого бізнесу. Він має прості функції, такі як візуальний редактор з інтерфейсом “наведи та клацни”.

- Спеціальний веб-API допомагає розробляти веб-програми, надаючи можливість отримувати веб-дані прямо з вашого веб-сайту.

7. Agenty

Agenty – це програма для очищення даних, вилучення тексту та розпізнавання тексту, яка використовує автоматизацію робочих процесів (RPA).

- Ця програма дозволяє перенаправити всі оброблені дані для аналітичних цілей.

- Ви можете створити агента всього за кілька кліків.

- Після виконання завдання ви отримаєте повідомлення електронною поштою.

- Agenty дозволяє підключатися до Dropbox і використовувати безпечний FTP.

- Всі журнали дій доступні для перегляду.

- Інструмент сприяє покращенню успіху вашого бізнесу.

- Agenty дозволяє легко впроваджувати бізнес-правила та користувацьку логіку.

8. Import.io

Програма для веб-скрейпінгу Import.io допомагає вам створювати набори даних, імпортуючи інформацію з веб-сторінок та експортуючи її у форматі CSV. Це також один з найкращих інструментів для веб-скрейпінгу. Нижче наведено основні функції цього інструменту.

- Робота з веб-формами та входом в систему проста.

- Import.io є одним з найкращих рішень для скрейпінгу даних, використовуючи API та веб-хуки для інтеграції даних у додатки.

- Ви можете отримати аналітичну інформацію за допомогою звітів, графіків та візуалізацій.

- Вилучення даних можна планувати наперед.

- Хмара Import.io дозволяє зберігати дані та отримувати до них доступ.

- Автоматизація взаємодії з інтернетом та робочих процесів є можливою.

9. Webz.io

Webz.io дозволяє сканувати сотні веб-сайтів та отримувати доступ до структурованих даних у режимі реального часу. Це також один з ефективних безкоштовних інструментів для веб-скрейпінгу.

Ви можете придбати організовані машиночитані набори даних у форматах JSON та XML.

- Він надає доступ до історичних каналів, які охоплюють дані за десятирічний період.

- Ви маєте можливість отримати доступ до великої бази даних інформаційних каналів без необхідності додаткових витрат.

- Можливе використання розширеного фільтра для детального аналізу та передачі даних.

10. Scrape Owl

Scrape Owl – це проста у використанні та економічна платформа для веб-скрейпінгу.

- Основна мета Scrape Owl – вилучення різних типів даних, зокрема з електронної комерції, дошок вакансій та оголошень нерухомості.

- Ви можете запускати свій JavaScript перед вилученням матеріалу.

- Користувачі можуть використовувати геолокацію для обходу місцевих обмежень та доступу до локального контенту.

- Scrape Owl забезпечує надійну функцію очікування.

- Підтримується повне відображення сторінок JavaScript.

- Цю програму можна використовувати безпосередньо в Google Sheets.

- Пропонується безкоштовна пробна версія з 1000 кредитами, щоб оцінити послугу перед оформленням будь-якої підписки. Кредитна картка не потрібна.

11. Scrapingbee

Scrapingbee – це API для веб-скрейпінгу, який керує налаштуваннями проксі-серверів та безголовими браузерами.

- Інструмент може виконувати Javascript на сторінках та автоматично змінювати проксі для кожного запиту, дозволяючи читати необроблений HTML без потрапляння до чорних списків.

- Доступний другий API для вилучення результатів пошуку Google.

- Підтримується рендеринг JavaScript.

- Scrapingbee має функцію автоматичної ротації проксі.

- Програму можна використовувати безпосередньо в Google Таблицях.

- Для використання програми необхідний веб-браузер Chrome.

- Він ідеально підходить для скрейпінгу Amazon.

- Можливе вилучення результатів Google.

12. Bright Data

Bright Data є провідною світовою платформою даних онлайн, яка пропонує економічне рішення для збору публічних веб-даних у великих масштабах, спрощення перетворення неструктурованих даних на структуровані та забезпечення відмінного досвіду клієнтів, будучи повністю прозорим та відповідним нормативним вимогам.

- Платформа є адаптивною, оскільки пропонує готові рішення, що можуть бути розширені та налаштовані.

- Збирач даних нового покоління Bright Data забезпечує автоматизований та персоналізований потік даних на одній інформаційній панелі, незалежно від розміру колекції.

- Підтримка клієнтів доступна 24/7.

- Набори даних адаптуються до потреб вашого бізнесу, від аналізу тенденцій електронної комерції та даних соціальних мереж до розвідки конкурентів та дослідження ринку.

- Автоматизація доступу до надійних даних у вашій галузі дозволяє зосередитися на основній діяльності.

- Bright Data є ефективною, оскільки використовує рішення без коду та споживає менше ресурсів.

- Платформа відрізняється надійністю, надаючи якісні дані, високий час безперебійної роботи, швидку обробку даних та відмінну підтримку клієнтів.

13. Scraper API

Ви можете використовувати інструмент Scraper API для управління проксі, браузерами та CAPTCHA.

- Інструмент забезпечує неперевершену швидкість та надійність, дозволяючи створювати масштабовані веб-скрепери.

- Ви можете отримати HTML будь-якої веб-сторінки за допомогою одного виклику API.

- Інструмент простий в налаштуванні, оскільки все, що потрібно зробити, це надіслати GET-запит зі своїм API-ключем та URL-адресою до кінцевої точки API.

- Scraper API полегшує рендеринг JavaScript.

- Можна налаштувати тип запиту та заголовки для кожного запиту.

- Інструмент підтримує ротацію проксі з географічним розташуванням.

14. Dexi Intelligent

Dexi Intelligent є онлайн-додатком для скрейпінгу, який дозволяє швидко перетворити будь-яку кількість веб-даних на комерційну цінність.

- Цей онлайн-інструмент для скрейпінгу дозволяє заощадити кошти та час для вашої компанії.

- Він покращує продуктивність, точність та якість.

- Dexi Intelligent забезпечує найшвидше та найефективніше вилучення даних.

- Інструмент має широкомасштабну систему збору знань.

15. Diffbot

Diffbot дозволяє швидко отримувати різноманітні важливі факти з інтернету.

- За допомогою AI Extractors ви можете отримувати точні структуровані дані з будь-якої URL-адреси.

- Вам не потрібно платити за трудомісткий перегляд веб-сайтів або ручні запити.

- Багато джерел даних об’єднуються для створення повного та точного зображення кожного об’єкта.

- Ви можете витягувати структуровані дані з будь-якої URL-адреси, використовуючи AI Extractors.

- За допомогою Crawlbot можна розширити вилучення до десятків тисяч доменів.

- Функція “Графік знань” надає точні, повні та глибокі дані, необхідні для бізнес-аналізу.

16. Data Streamer

Data Streamer – це технологія, яка дозволяє отримувати матеріали з соціальних мереж з усього інтернету.

- Це один з найбільших онлайн-скреперів, який використовує обробку природної мови для отримання важливих метаданих.

- Kibana та Elasticsearch використовуються для забезпечення інтегрованого повнотекстового пошуку.

- Інструмент базується на алгоритмах пошуку інформації, інтегрованого видалення шаблонів та вилучення контенту.

- Data Streamer побудований на відмовостійкій інфраструктурі для забезпечення високої доступності інформації.

17. Mozenda

За допомогою Mozenda можна вилучати текст, фотографії та PDF-матеріали з веб-сторінок.

- Користувачі можуть використовувати інструменти Bl або базу даних на свій вибір для збору та публікації даних в інтернеті.

- Mozenda є одним з найкращих онлайн-інструментів для впорядкування та форматування файлів даних для публікації.

- За допомогою інтерфейсу “наведи та клацни” можна створити агенти веб-скрейпінгу за лічені хвилини.

- Для збору веб-даних у реальному часі використовуйте функції Job Sequencer та Request Blocking.

- Управління обліковими записами та обслуговування клієнтів є одними з найкращих у галузі.

18. Розширення Data Miner Chrome

Веб-скрейпінг та збір даних спрощується за допомогою плагіна Data Miner для веб-переглядача.

- Він має можливість сканування кількох сторінок, а також динамічне вилучення даних.

- Вибір даних можна здійснювати різними способами.

- Інструмент перевіряє інформацію, що була вилучена.

- Отримані дані можна зберегти як файл CSV.

- Для зберігання зашифрованих даних використовується локальне сховище.

- Доповнення Chrome Web Scraper витягує дані з динамічних веб-сайтів.

- Можливий імпорт та експорт карт сайту.

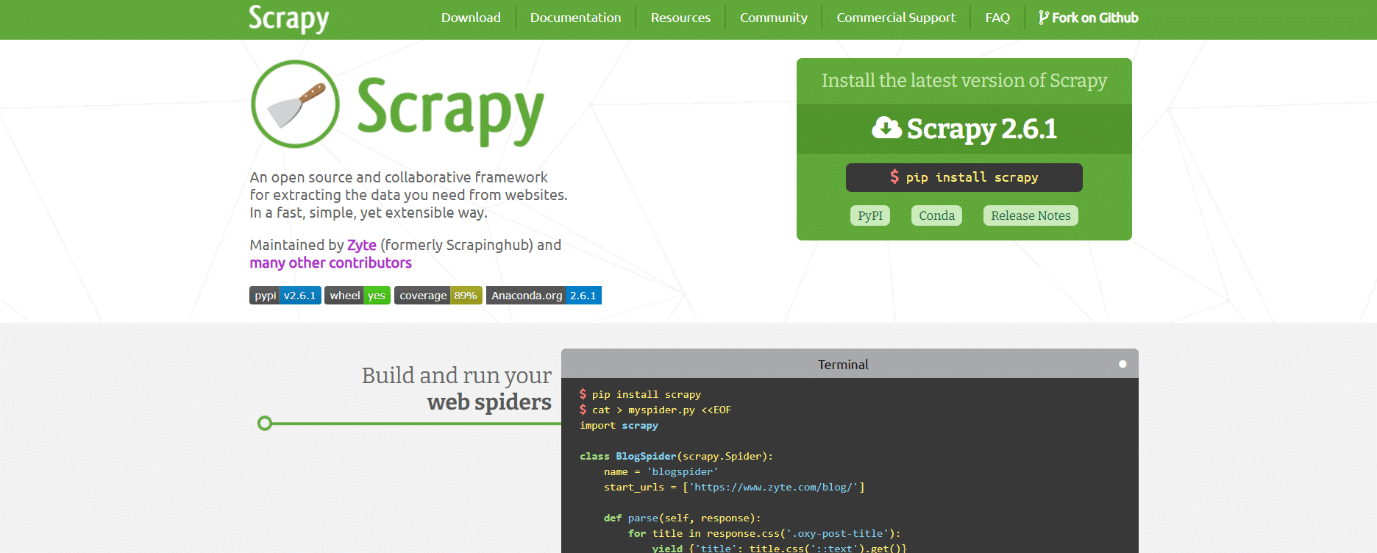

19. Scrapy

Scrapy також є одним із найкращих інструментів для веб-скрейпінгу. Це фреймворк онлайн-скрейпінгу з відкритим кодом на основі Python для створення веб-скреперів.

- Він надає всі необхідні інструменти для швидкого вилучення даних з веб-сайтів, їх аналізу та зберігання у вибраній структурі та форматі.

- Цей інструмент для шифрування даних є незамінним для великих проєктів скрейпінгу даних, де необхідна максимальна ефективність та гнучкість.

- Дані можна експортувати у форматах JSON, CSV або XML.

- Інструмент підтримує Linux, Mac OS X та Windows.

- Він розроблений на основі технології асинхронної мережі Twisted, яка є однією з його ключових особливостей.

- Scrapy вирізняється простотою використання, великою документацією та активною спільнотою користувачів.

20. ScrapeHero Cloud

ScrapeHero використав свій багаторічний досвід у скануванні веб-сторінок для створення економічно ефективних та простих у використанні попередньо розроблених сканерів та API для вилучення даних із таких сайтів, як Amazon, Google, Walmart та інші.

- Сканер ScrapeHero Cloud включає в себе проксі, що автоматично обертається, та можливість одночасного запуску багатьох сканерів.

- Для використання ScrapeHero Cloud не потрібно завантажувати будь-які інструменти або програмне забезпечення для зняття даних, а також вивчати їх.

- Сканер ScrapeHero Cloud дозволяє миттєво збирати дані та експортувати їх у формати JSON, CSV або Excel.

- Клієнти безкоштовного та спрощеного плану ScrapeHero Cloud отримують підтримку електронною поштою, тоді як усі інші плани мають пріоритетну послугу.

- Сканер ScrapeHero Cloud також може бути налаштований відповідно до конкретних вимог клієнтів.

- Це веб-скрепер на основі браузера, який працює з будь-яким веб-браузером.

- Вам не потрібні навички програмування чи розробка скрепера; достатньо просто клацнути, скопіювати та вставити!

21. Data Scraper

Data Scraper – це безкоштовна онлайн-програма для скрейпінгу, яка витягує дані з однієї веб-сторінки та зберігає їх у файлі CSV або XSL.

- Це розширення для браузера, яке перетворює дані в зручний табличний формат.

- Для встановлення плагіна необхідно використовувати браузер Google Chrome.

- Безкоштовна версія дозволяє скрейпити 500 сторінок щомісяця; для отримання більшої кількості сторінок необхідно перейти до одного з платних планів.

22. Visual Web Ripper

Visual Web Ripper – це інструмент автоматичного очищення даних для веб-сайтів.

- Інструмент збирає структури даних з веб-сайтів або результатів пошуку.

- Дані можна експортувати у файли CSV, XML та Excel, а сам інструмент має зручний інтерфейс.

- Visual Web Ripper може збирати дані з динамічних веб-сайтів, зокрема тих, що використовують AJAX.

- Користувачу потрібно налаштувати лише кілька шаблонів, а веб-скрепер виконає все інше.

- Visual Web Ripper пропонує параметри планування і навіть надсилає сповіщення на електронну пошту у разі збою проєкту.

23. Octoparse

Octoparse – це зручна програма для перегляду веб-сторінок з візуальним інтерфейсом. Це один з ефективних безкоштовних інструментів для веб-скрейпінгу. Нижче перераховані основні особливості цього інструменту.

- Інтерфейс “наведи та клацни” дозволяє легко обирати потрібну для вилучення інформацію з веб-сайту. Octoparse може обробляти як статичні, так і динамічні веб-сторінки завдяки AJAX, JavaScript, файлам cookie та іншим можливостям.

- Наразі доступні передові хмарні сервіси, які дозволяють отримувати великі обсяги даних.

- Отриману інформацію можна зберігати у форматах TXT, CSV, HTML або XLSX.

- Безкоштовна версія Octoparse дозволяє створити до 10 сканерів; проте платні плани підписки включають такі функції, як API та велика кількість анонімних IP-проксі, що прискорить процес вилучення та дозволить завантажувати великі обсяги даних у реальному часі.

24. WebHarvy

Візуальний веб-скрепер WebHarvy має вбудований браузер для запису даних з онлайн-сайтів. Це також один з найкращих інструментів для веб-скрейпінгу. Ось деякі особливості цього інструменту.

- Він має інтерфейс “наведи й клацни”, що спрощує вибір елементів.

- Основною перевагою цього скрепера є те, що він не вимагає написання коду.

- Для збереження даних можна використовувати файли CSV, JSON та XML.

- Інформацію також можна зберігати в базі даних SQL. WebHarvy має багаторівневу функцію скрейпінгу категорій, яка може видаляти дані зі сторінок списку, дотримуючись кожного рівня з’єднань категорій