Чи шукаєте ви способи підвищити ефективність SEO, розширити охоплення аудиторії та збільшити конверсію? У такому випадку вам не обійтися без інструменту веб-сканування. Веб-сканер – це програмне забезпечення, призначене для автоматизованого перегляду веб-сторінок в інтернеті. Серед прикладів таких технологій можна виділити веб-павуків, програми для вилучення даних з веб-сайтів і інструменти для скрейпінгу. Також їх називають ботами або павуками. Сьогодні ми розглянемо декілька безкоштовних інструментів веб-сканування, які можна завантажити.

25 кращих безкоштовних інструментів веб-сканування

Інструменти веб-сканування надають важливі дані для аналізу та прийняття обґрунтованих рішень. Їх основна мета – індексація веб-сторінок. Вони здатні виявляти непрацюючі посилання, дубльований контент, відсутні заголовки сторінок та інші серйозні проблеми, що впливають на SEO. Збір онлайн-даних може допомогти вашому бізнесу різними способами.

- Багато сканерів можуть ефективно збирати дані з будь-якої URL-адреси веб-сайту.

- Ці програми допомагають покращити структуру вашого веб-ресурсу, роблячи його зрозумілішим для пошукових систем і сприяючи підвищенню рейтингу.

Ми підібрали список найкращих інструментів для безкоштовного завантаження, а також вказали їхні основні можливості та вартість. Серед них є як безкоштовні, так і платні варіанти, з яких ви можете вибрати оптимальний для себе.

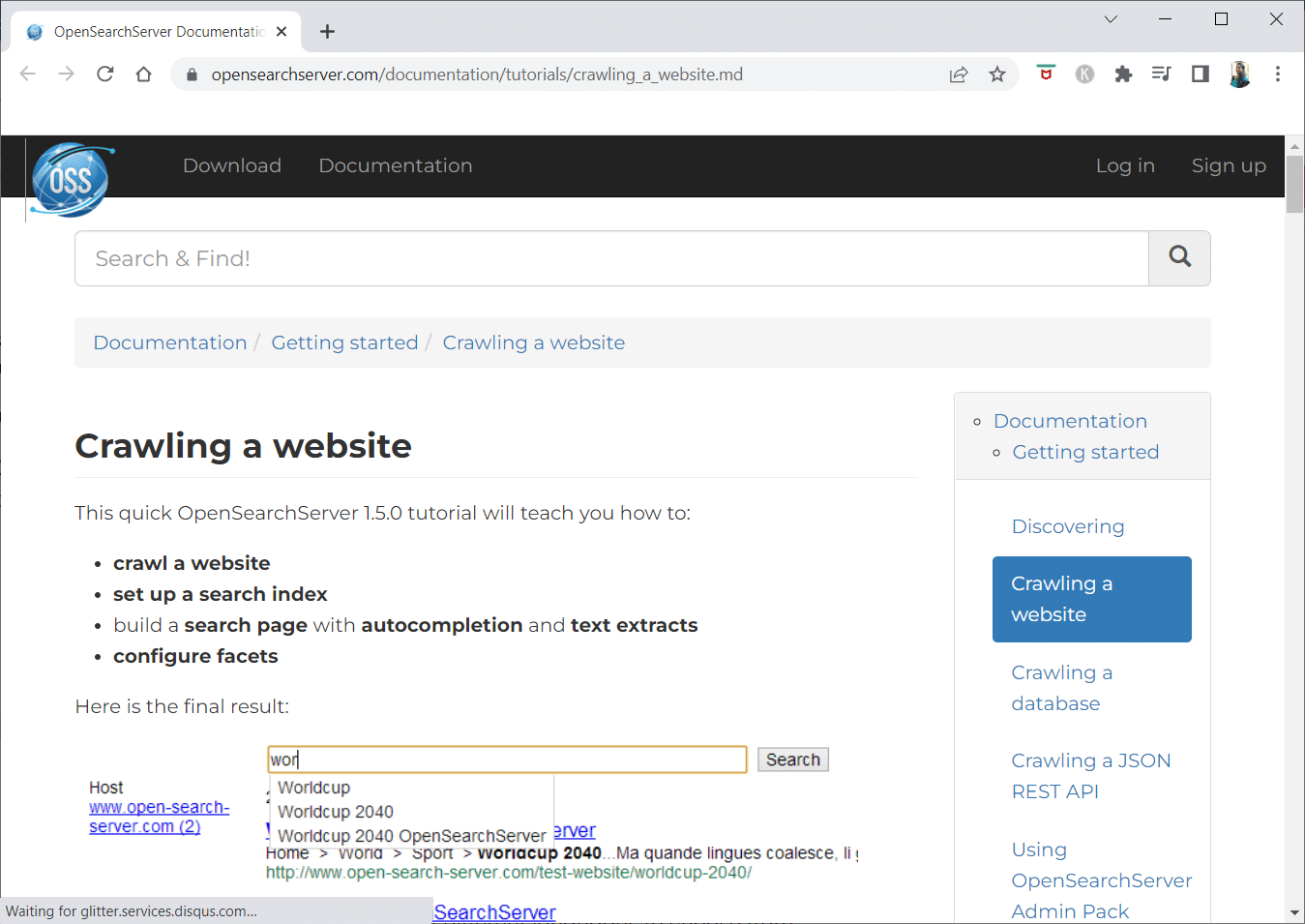

1. Open Search Server

OpenSearchServer – це безкоштовний веб-сканер з високим рейтингом, що є однією з кращих альтернатив на ринку.

- Це комплексне рішення, що включає всі необхідні функції.

- Open Search Server є безкоштовною пошуковою системою з відкритим вихідним кодом.

- Це ефективне та економічно вигідне рішення.

- Інструмент пропонує повний набір можливостей для пошуку та гнучкість у налаштуванні стратегії індексування.

- Сканер здатний індексувати практично будь-який тип контенту.

- Доступний повнотекстовий, логічний та фонетичний пошук.

- Ви можете вибрати одну з 17 мов.

- Підтримується автоматична класифікація.

- Можливе створення розкладів для автоматичного виконання завдань.

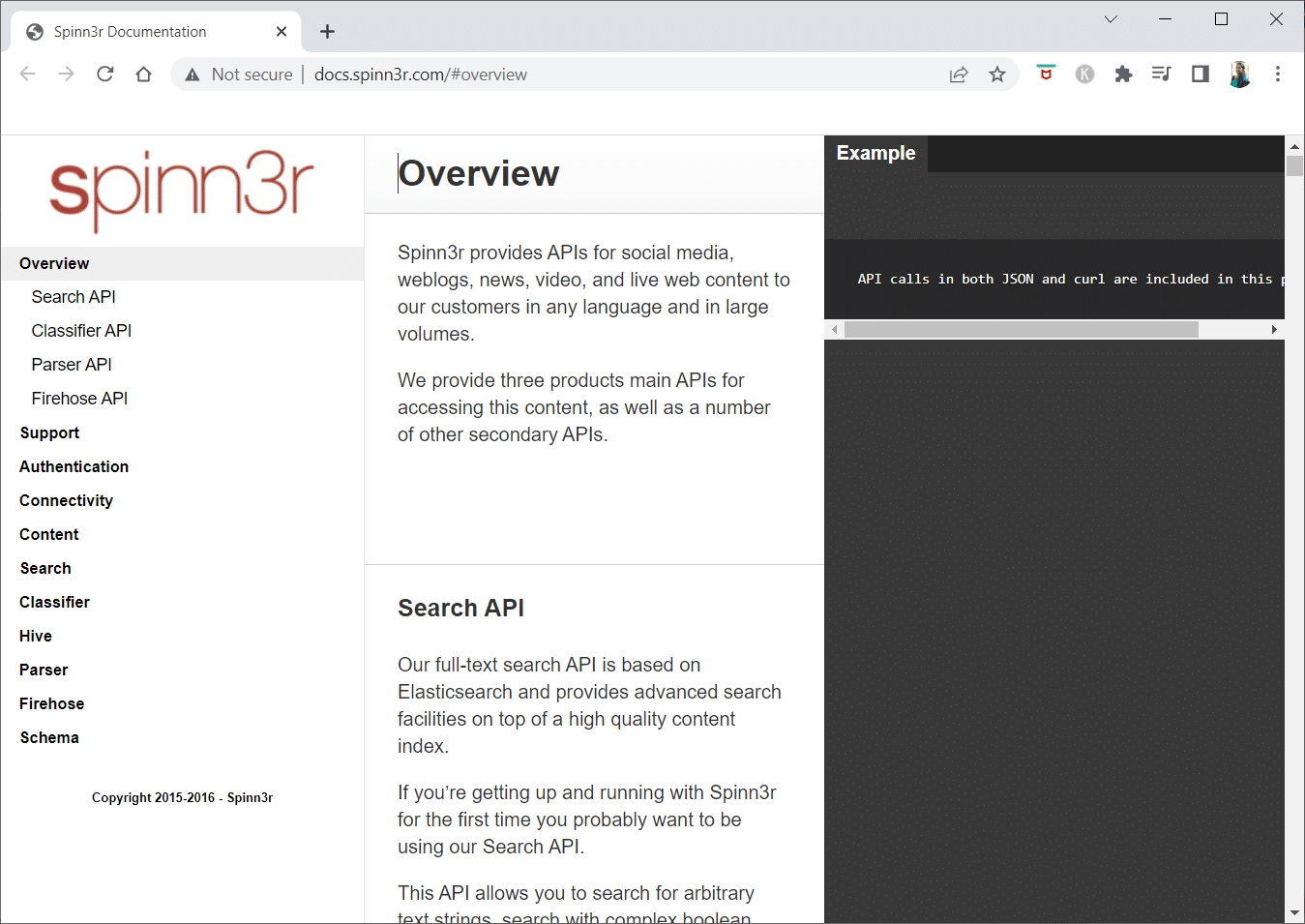

2. Spinn3r

Spinn3r – це веб-сканер, що дозволяє витягувати контент з блогів, новинних сайтів, соціальних мереж, RSS-каналів та ATOM-каналів.

- Інструмент має швидкий API, який обробляє 95% завдань, пов’язаних з індексуванням.

- Він включає розширений захист від спаму, що фільтрує небажаний контент та ненормативну лексику, підвищуючи безпеку даних.

- Веб-скребок постійно перевіряє різні джерела, щоб надавати оновлення в режимі реального часу.

- Він індексує контент подібно до Google, а витягнуті дані зберігаються у форматі JSON.

- API аналізатора дозволяє швидко аналізувати інформацію з різних URL-адрес.

- Firehose API створено для обробки великих обсягів даних.

- Для аутентифікації API Spinn3r використовуються прості HTTP-заголовки.

- Це безкоштовний інструмент веб-сканування.

- API класифікатора дозволяє розробникам відправляти текст або URL-адреси для аналізу за допомогою технології машинного навчання.

3. Import.io

Import.io дає можливість витягувати дані з мільйонів веб-сторінок за лічені хвилини та створювати понад 1000 API, що відповідають вашим потребам, без необхідності писати код.

- Інструмент дозволяє автоматизувати отримання даних.

- Витягуйте дані з багатьох сторінок за допомогою одного кліку.

- Він здатний розпізнавати сторінки, розбиті на частини, та дозволяє переходити по них.

- Вбудовуйте онлайн-дані у ваш додаток або веб-сайт у кілька кліків.

- Створюйте потрібні URL-адреси за допомогою шаблонів, таких як номери сторінок та назви категорій.

- Import.io демонструє, як легко витягувати дані зі сторінок. Просто виберіть стовпець з вашого набору даних та вкажіть на елемент на сторінці.

- Ви можете запросити пропозицію на їхньому веб-сайті.

- Посилання на сторінках списку ведуть до детальних сторінок з додатковою інформацією.

- Використовуйте Import.io, щоб отримати всі дані зі сторінок інформації одночасно.

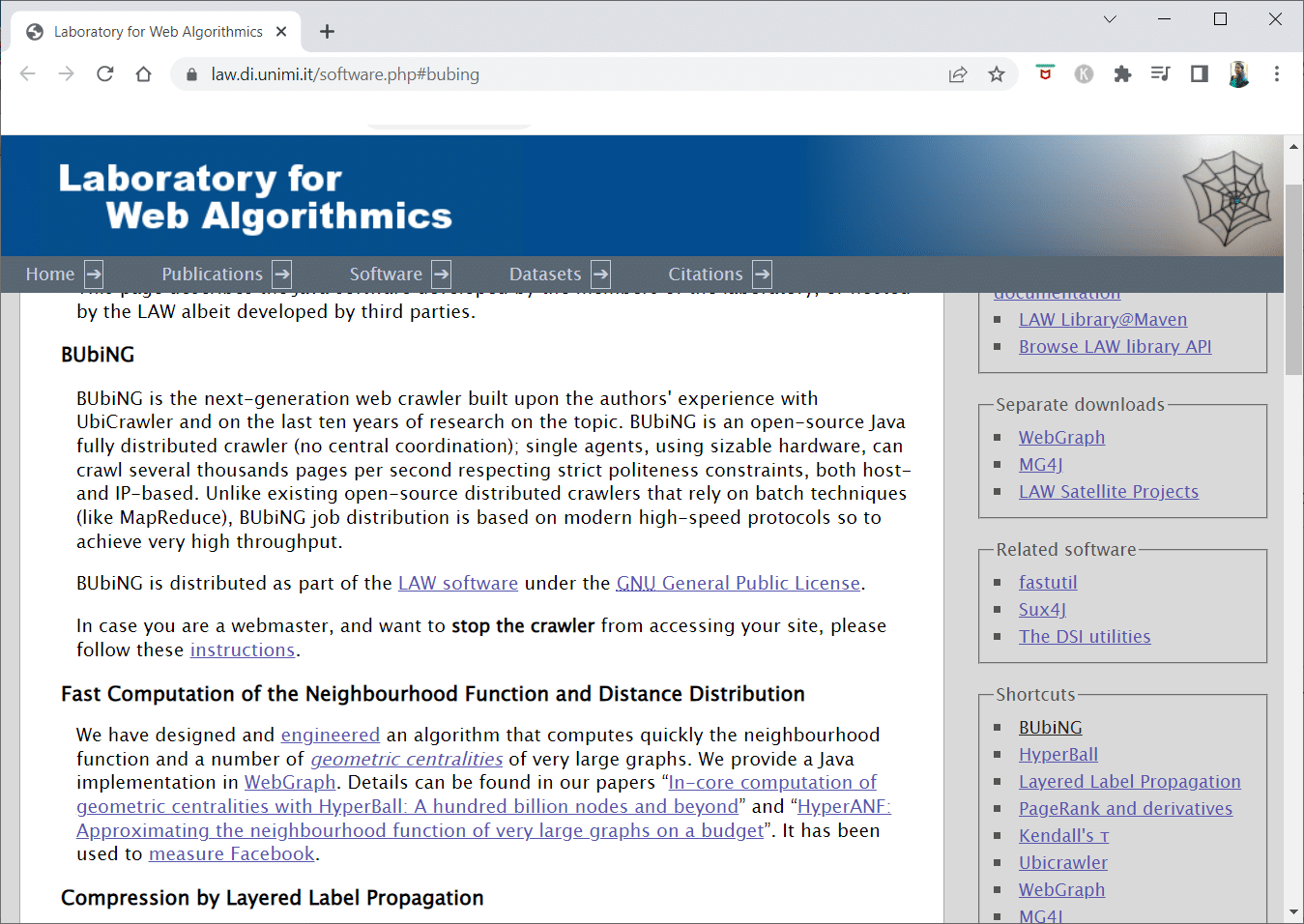

4. BUbiNG

BUbiNG – це інструмент веб-сканування нового покоління, який є кульмінацією досвіду розробників з UbiCrawler та десятирічних досліджень у цій галузі.

- Один агент може сканувати тисячі сторінок за секунду, дотримуючись строгих стандартів ввічливості.

- Розподіл завдань базується на сучасних високошвидкісних протоколах, що забезпечують високу пропускну здатність.

- Інструмент використовує відбитки пальців для виявлення майже дублікатів.

- BUbiNG – це повністю розподілений сканер Java з відкритим вихідним кодом.

- Він пропонує високий рівень паралелізму.

- Багато користувачів вже використовують цей інструмент.

- Він відрізняється швидкістю та ефективністю.

- BUbiNG пропонує можливості для широкомасштабного сканування.

5. GNU Wget

GNU Wget – це безкоштовний інструмент веб-сканування з відкритим вихідним кодом, написаний на C, який дозволяє завантажувати файли через HTTP, HTTPS, FTP та FTPS.

- Однією з важливих особливостей є можливість створювати файли повідомлень NLS різними мовами.

- Ви можете перезапускати завантаження, які були зупинені, використовуючи REST та RANGE.

- Інструмент може перетворювати абсолютні посилання в завантажених документах у відносні.

- Підтримує рекурсивне використання символів підстановки в іменах файлів та каталогах.

- Файли повідомлень NLS доступні для різних мов.

- Під час дзеркалювання перевіряються мітки часу локальних файлів, щоб визначити необхідність повторного завантаження.

6. Webhose.io

Webhose.io – це програма веб-сканування, що дозволяє збирати дані та витягувати ключові слова різними мовами, використовуючи фільтри, що охоплюють широкий діапазон джерел.

- Архів дозволяє користувачам переглядати минулі дані.

- Пошук у даних сканування Webhose.io доступний 80 мовами.

- Вся зламана особиста інформація доступна в одному місці.

- Досліджуйте темну мережу та месенджери на предмет кіберзагроз.

- Дані можуть бути записані у форматах XML, JSON та RSS.

- Ви можете запросити пропозицію на їхньому веб-сайті.

- Користувачі можуть індексувати та шукати структуровані дані на Webhose.io.

- Інструмент може відстежувати та аналізувати ЗМІ всіма мовами.

- Можливе відстеження обговорень на дошках оголошень та форумах.

- Інструмент відстежує ключові публікації блогів в інтернеті.

7. Norconex

Norconex – це чудовий ресурс для компаній, які шукають програму веб-сканування з відкритим вихідним кодом.

- Інструмент може використовуватися як окрема програма або інтегруватися у вашу систему.

- Він також може збирати зображення зі сторінок.

- Norconex дозволяє сканувати вміст будь-якого веб-сайту.

- Можливе використання на будь-якій операційній системі.

- Програма може сканувати мільйони сторінок на одному сервері середньої потужності.

- Інструмент включає набір інструментів для зміни контенту та метаданих.

- Отримуйте метадані для документів, над якими ви працюєте.

- Підтримуються сторінки, що відтворюються JavaScript.

- Інструмент підтримує визначення мов контенту.

- Доступна допомога з перекладом.

- Можливе налаштування швидкості сканування.

- Ідентифікуються змінені або видалені документи.

- Це безкоштовна програма веб-сканування.

8. Dexi.io

Dexi.io – це веб-сканер на основі браузера, який дозволяє витягувати інформацію з будь-якого веб-сайту.

- Екстрактори, гусеничні пристрої та труби – це три типи роботів, які можна використовувати для виконання скрейпінгу.

- Звіти Delta дозволяють відстежувати тенденції ринку.

- Зібрані дані зберігаються протягом двох тижнів на серверах Dexi.io або можуть бути негайно експортовані у форматі JSON або CSV.

- Ви можете запросити пропозицію на їхньому веб-сайті.

- Пропонуються професійні послуги, такі як гарантія якості та технічне обслуговування.

- Він пропонує комерційні послуги для задоволення ваших потреб у даних в режимі реального часу.

- Можна відстежувати запаси та ціни на необмежену кількість продуктів.

- Інструмент дозволяє інтегрувати дані за допомогою оперативних інформаційних панелей та аналітики продуктів.

- Це допоможе підготувати та обробити структуровані дані про продукти з інтернету.

9. Zyte

Zyte – це хмарний інструмент вилучення даних, який допомагає розробникам отримувати важливу інформацію. Це одна з найкращих безкоштовних програм для веб-сканування.

- Користувачі можуть витягувати дані з веб-сторінок за допомогою програми візуального скрейпінгу без написання коду.

- Crawlera, складний ротатор проксі-сервера, який використовується Zyte, дозволяє користувачам легко сканувати великі або захищені ботом сайти.

- Онлайн-інформація надходить за графіком і послідовно, що дозволяє вам зосередитися на обробці даних.

- Інструмент пропонує можливості розумного браузера та захист від ботів.

- Ви можете запросити пропозицію на їхньому веб-сайті.

- Користувачі можуть сканувати з різних IP-адрес і регіонів, використовуючи простий HTTP API, що усуває необхідність обслуговування проксі.

- Інструмент допомагає заощаджувати час та гроші, надаючи необхідну інформацію.

- Він дозволяє отримувати веб-дані у великих масштабах, заощаджуючи час на кодування та обслуговування павуків.

10. Apache Nutch

Apache Nutch – це веб-сканер з відкритим вихідним кодом, який посідає чільне місце серед подібних інструментів.

- Він може працювати на одному комп’ютері, але краще працює на кластері Hadoop.

- Для аутентифікації використовується протокол NTLM.

- Інструмент має розподілену файлову систему (через Hadoop).

- Це добре відоме програмне забезпечення для вилучення даних, яке масштабується та адаптується до різних потреб.

- Його використовують аналітики даних, науковці, розробники додатків та спеціалісти з аналізу веб-текстів по всьому світу.

- Це кросплатформне рішення на основі Java.

- Вибірка та синтаксичний аналіз за замовчуванням виконуються незалежно.

- Дані відображаються за допомогою XPath та просторів імен.

- Інструмент містить базу даних графіків посилань.

11. VisualScraper

VisualScraper – це веб-скребок без коду для вилучення даних з інтернету.

- Він пропонує простий користувацький інтерфейс “наведи і клацни”.

- Інструмент також пропонує онлайн-послуги скрейпінгу, розповсюдження даних та створення програмних екстракторів.

- Він також дозволяє відстежувати ваших конкурентів.

- Користувачі можуть планувати виконання проектів у певний час або налаштовувати повторення послідовності щохвилини, дня, тижня, місяця та року.

- Інструмент є ефективним та економічно вигідним.

- Немає необхідності використовувати кодування.

- Це безкоштовна програма веб-сканування.

- Дані в режимі реального часу можна отримувати з різних веб-сторінок та зберігати у форматах CSV, XML, JSON або SQL.

- Користувачі можуть використовувати інструмент для отримання новин, оновлень та повідомлень на форумі.

- Дані є точними та налаштованими.

12. WebSphinx

WebSphinx – це безкоштовна програма-сканер, яку легко налаштувати та використовувати.

- Він призначений для досвідчених користувачів інтернету та програмістів Java, які хочуть автоматично сканувати певну частину інтернету.

- Це онлайн-рішення для вилучення даних включає бібліотеку класів Java та інтерактивне середовище програмування.

- Сторінки можна об’єднати в один документ для перегляду або друку.

- Витягуйте текст, що відповідає заданому шаблону, з послідовності сторінок.

- Інструмент дозволяє створювати веб-сканери на Java.

- Пакет включає інструмент Crawler Workbench та бібліотеку класів WebSPHINX.

- Crawler Workbench – це графічний інтерфейс користувача для налаштування веб-сканера.

- З групи веб-сторінок можна скласти графік.

- Зберігайте сторінки на локальному диску для перегляду в автономному режимі.

13. OutWit Hub

OutWit Hub – це платформа, що включає ядро з великою бібліотекою можливостей розпізнавання та вилучення даних, на основі якої можна створити різноманітні програми.

- Ця програма-сканер може сканувати веб-сайти та зберігати виявлені дані.

- Це багатоцільовий інструмент з великою кількістю функцій для різних потреб.

- OutWit Hub існує досить давно.

- Він трансформувався у корисну платформу для нетехнічних користувачів та фахівців, які розуміють кодування.

- OutWit Hub надає єдиний інтерфейс для отримання малих або великих обсягів даних.

- Інструмент дозволяє витягувати дані з веб-сторінки прямо з браузера та створювати автоматизованих агентів, які збирають дані.

- Ви можете запросити пропозицію на їхньому веб-сайті.

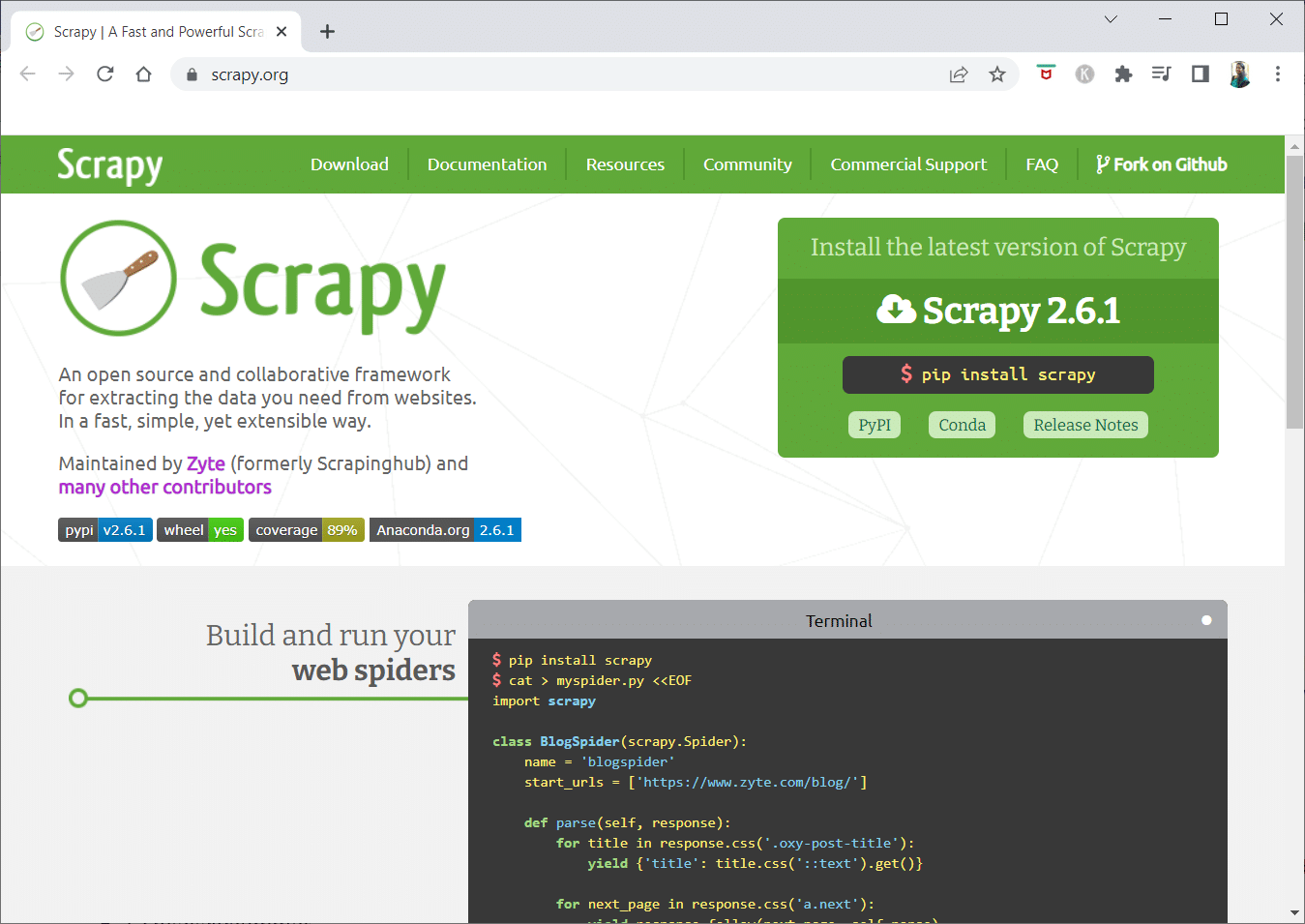

14. Scrapy

Scrapy – це онлайн-фреймворк Python для створення масштабованих веб-сканерів.

- Це повноцінний фреймворк, що обробляє всі характеристики, які ускладнюють створення веб-сканерів.

- Ви можете написати правила для вилучення даних, а Scrapy зробить все інше.

- Інструмент легко розширювати, додаючи нові функції.

- Це програма на основі Python, яка працює в системах Linux, Windows, Mac OS X та BSD.

- Це безкоштовний інструмент.

- Його бібліотека надає програмістам готову структуру для налаштування веб-сканера та вилучення даних.

15. Mozenda

Mozenda – це хмарна програма для веб-скрейпінгу з орієнтацією на бізнес, що є одним з кращих безкоштовних інструментів веб-сканування. Mozenda обробила понад 7 мільярдів сторінок та має клієнтів по всьому світу.

- Технологія веб-скрейпінгу Mozenda усуває необхідність використовувати скрипти та наймати інженерів.

- Інструмент прискорює збір даних у п’ять разів.

- Ви можете витягувати текст, файли, зображення та інформацію PDF з веб-сайтів за допомогою функції Mozenda “наведи і клацни”.

- Після організації файлів даних ви можете підготувати їх до публікації.

- Ви можете експортувати дані у формати TSV, CSV, XML, XLSX або JSON за допомогою API Mozeda.

- Використовуйте систему Data Wrangling від Mozenda для структурування інформації, щоб приймати важливі рішення.

- Можлива інтеграція даних на різних платформах.

16. Cyotek WebCopy

Cyotek WebCopy – це безкоштовний веб-сканер, що автоматично завантажує вміст веб-сайту на локальний пристрій.

- Вміст вибраного веб-сайту буде відскановано та завантажено.

- Ви можете вибрати, які частини веб-сайту клонувати, використовуючи структуру інструменту.

- Новий локальний маршрут буде переспрямовувати посилання на ресурси, такі як таблиці стилів, зображення та інші сторінки.

- Інструмент проаналізує HTML-розмітку веб-сайту та спробує знайти підключені ресурси, такі як інші веб-сайти, фотографії, відео, файли тощо.

- Він може сканувати веб-сайт і завантажувати весь контент, створюючи копію оригіналу.

17. Common Crawl

Common Crawl був розроблений для всіх, хто зацікавлений у дослідженні та аналізі даних для отримання корисної інформації.

- Це неприбуткова організація, що покладається на пожертвування для своєї діяльності.

- Будь-хто може використовувати Common Crawl безкоштовно.

- Common Crawl – це корпус, що використовується для навчання, досліджень та аналізу.

- Ознайомтеся зі статтями, якщо ви не маєте технічних навичок, щоб дізнатися про відкриття, зроблені іншими, використовуючи дані Common Crawl.

- Викладачі можуть використовувати ці інструменти для навчання аналізу даних.

18. Semrush

Semrush – це веб-сканер, що перевіряє сторінки та структуру веб-сайту на предмет технічних проблем SEO. Вирішення цих проблем допоможе покращити ваші результати в пошуку.

- Інструмент включає можливості для SEO, дослідження ринку, маркетингу в соціальних мережах та реклами.

- Semrush має зручний інтерфейс.

- Інструмент досліджує метадані, HTTP/HTTPS, директиви, коди статусу, повторюваний вміст, швидкість відгуку сторінки, внутрішні посилання, розміри зображень, структуровані дані та інші елементи.

- Проведення аудиту вашого веб-сайту стає швидшим та простішим.

- Semrush допомагає аналізувати файли журналів.

- Інструмент надає інформаційну панель для перегляду проблем веб-сайту.

19. Sitechecker.pro

Sitechecker.pro – це ще один безкоштовний веб-сканер. Це SEO-інструмент для перевірки веб-сайтів, що допомагає підвищити рейтинг SEO.

- Структуру веб-сторінки легко уявити.

- Інструмент створює звіт SEO-аудиту, що відправляється клієнтам електронною поштою.

- Веб-сканер перевіряє внутрішні та зовнішні посилання вашого веб-сайту.

- Інструмент допомагає визначити швидкість веб-сайту.

- Sitechecker.pro дозволяє перевірити наявність проблем з індексацією на цільових сторінках.

- Інструмент допомагає захиститися від хакерських атак.

20. WebHarvy

WebHarvy – це інструмент для веб-скрейпінгу з простим інтерфейсом “наведи і клацни”. Він розроблений для користувачів без навичок кодування.

- Вартість ліцензії починається від 139 доларів.

- Використовуйте вбудований браузер WebHarvy для завантаження веб-сайтів та вибору даних для вилучення.

- Інструмент може автоматично вилучати текст, фотографії, URL-адреси та електронні листи з веб-сайтів.

- Для доступу до цільових веб-сайтів можна використовувати проксі-сервери або VPN.

- Збір даних не вимагає створення програм або додатків.

- WebHarvy автоматично визначає шаблони даних на веб-сайтах.

- Якщо потрібно витягти список об’єктів зі сторінки, нічого додатково робити не потрібно.

21. NetSpeak Spider

NetSpeak Spider – це веб-сканер для щоденних SEO-аудитів, виявлення проблем та перегляду веб-сторінок.

- Ця програма сканує великі веб-сторінки з мінімальним використанням оперативної пам’яті.

- Файли CSV можна легко імпортувати та експортувати з даних веб-сканування.

- Інструмент дозволяє виявити проблеми SEO за кілька кліків.

- Він допоможе оцінити оптимізацію веб-сайту, включаючи код статусу, інструкції сканування, структуру та перенаправлення.

- Дані з Google Analytics та Yandex можуть бути експортовані.

- Враховуйте діапазон даних, тип пристрою та сегментацію для сторінок свого веб-сайту.

- Місячна підписка починається від 21 долара.

- Сканер виявляє непрацюючі посилання та зображення, а також повторювані матеріали, наприклад, заголовки та мета-описи.

22. UiPath

UiPath – це онлайн-інструмент для веб-сканування, що дозволяє автоматизувати роботизовані процеси. Він автоматизує сканування даних в інтернеті та на настільних комп’ютерах.

- Програму можна встановити в Windows.

- Інструмент може витягувати дані в табличній формі та у формі на основі шаблонів з багатьох веб-сторінок.

- UiPath може здійснювати додаткові сканування відразу після встановлення.

- Звіти відстежують роботу ваших роботів, щоб ви могли звертатися до документації.

- Результати будуть ефективнішими та успішнішими при стандартиза