Як часто ви покладаєтеся на чат-ботів або ботів на основі штучного інтелекту (ШІ), щоб виконати роботу або відповісти на запитання?

Якщо ваша відповідь “багато!” або «весь час!», у вас є привід хвилюватися😟.

Незалежно від того, чи є ви студентом-дослідником, який регулярно використовує ШІ-ботів для дослідження своїх документів, чи програмістом, який намагається генерувати коди лише за допомогою ШІ, ймовірність неточності в результатах, згенерованих ШІ, є досить високою — насамперед через невідповідності чи оманливі дані в ШІ. навчальні дані.

Незважаючи на те, що моделі штучного інтелекту та машинного навчання (ML) змінюють світ, беручи на себе надлишкові завдання та вирішуючи багато проблем за допомогою автоматизації, їм ще потрібно попрацювати, коли справа доходить до створення точних результатів на основі наданих підказок.

Якщо ви витрачаєте достатньо часу на використання генераторів контенту та чат-ботів, незабаром ви зрозумієте, що отримуєте неправдиві, нерелевантні чи просто вигадані відповіді. Ці випадки називаються галюцинаціями ШІ або конфабуляціями, і вони виявляються величезною проблемою для організацій і окремих осіб, які покладаються на генеративних ботів ШІ.

Незалежно від того, відчували ви галюцинації штучного інтелекту чи ні і хочете дізнатися більше, ця стаття глибоко занурюється в цю тему. Ми побачимо, що означає галюцинація ШІ, чому це відбувається, приклади та чи можна це виправити.

Ходімо!

Що таке AI галюцинація?

Галюцинація ШІ — це коли модель ШІ або Велика мовна модель (LLM) генерує неправдиву, неточну або нелогічну інформацію. Модель штучного інтелекту генерує впевнену відповідь, яка насправді не збігається з навчальними даними та представляє дані як факт, незважаючи на відсутність логічного сенсу чи аргументації!

А кажуть, помилятися властиво людині!😅

Інструменти та моделі ШІ, такі як ChatGPT, зазвичай навчені передбачати слова, які найкраще відповідають заданому запиту. Хоча боти часто генерують фактичні та точні відповіді, іноді цей алгоритм змушує їх обґрунтовуватись, змушуючи чат-ботів викидати фактичні невідповідності та неправдиві твердження.

Іншими словами, моделі штучного інтелекту іноді «галюцинують» відповідь, намагаючись догодити вам (користувачу) — вони повинні бути більш упередженими, упередженими, спеціалізованими або достатніми.

Галюцинації штучного інтелекту можуть варіюватися від незначних невідповідностей до повністю хибних або сфабрикованих відповідей. Ось типи галюцинацій ШІ, які ви можете відчувати:

#1. Протиріччя речення: це трапляється, коли модель LLM генерує речення, яке повністю суперечить її попередньому заявленню.

#2. Фактичне протиріччя: цей тип галюцинацій виникає, коли модель штучного інтелекту представляє підроблену або вигадану інформацію як факт.

#3. Протиріччя підказки: цей тип галюцинації виникає, коли результат суперечить підказці, для якої він генерує вихід. Наприклад, якщо запит «Напишіть моїм друзям запрошення на мій день народження». Модель може генерувати вихідні дані на кшталт «З річницею, мама й тато».

#4. Випадкові або нерелевантні галюцинації: ця галюцинація виникає, коли модель генерує абсолютно нерелевантні результати для заданої підказки. Наприклад, якщо підказка: «Що особливого в Нью-Йорку?» Ви можете отримати повідомлення: «Нью-Йорк — одне з найбільш багатолюдних міст Америки. Собаки – найвірніші тварини і найкращі друзі людини».

Читайте також: Як Generative AI Search змінює пошукові системи

Приклади ШІ Галюцинації

Галюцинації штучного інтелекту мають деякі з найбільш помітних прикладів і інцидентів, які ви не повинні пропустити. Ось сумно відомі приклади галюцинацій ШІ:

- Чат-бот Google Bard неправдиво заявив, що космічний телескоп Джеймса Вебба зробив перші в світі зображення екзопланети, яка не належить до нашої Сонячної системи.

- Демонстрація Meta Galactica LLM у 2022 році, розроблена для студентів і наукових дослідників, надала своїм користувачам неточну інформацію та підроблений документ, коли їм було запропоновано написати документ про створення аватарів.

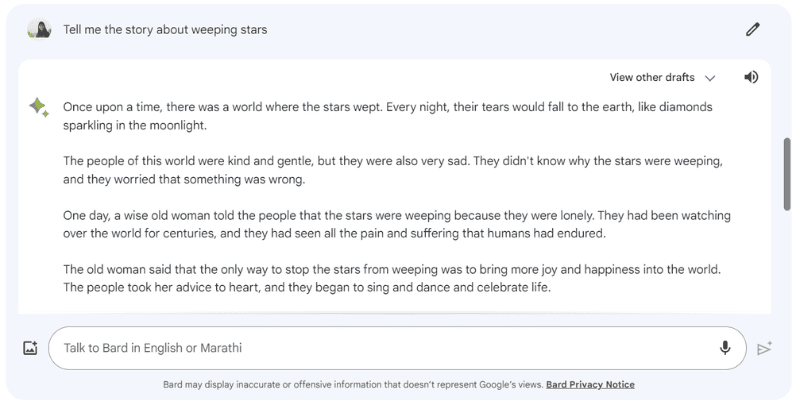

Ось приклад галюцинації відповіді Google Bard, коли я дав йому запит: «Розкажи мені історію про плачуть зірки», якої насправді не існує.

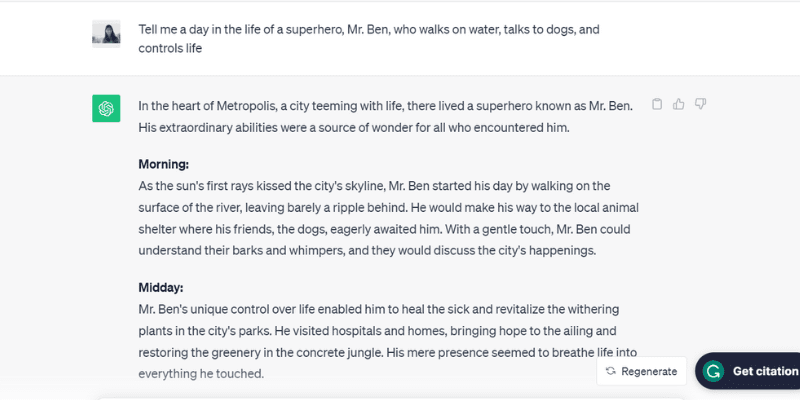

Ось ще один перевірений приклад галюцинації ChatGPT (GPT-3.5), який говорить про нереалістичну людину, містера Бена, коли я дав йому підказку: «Розкажіть мені день із життя супергероя, містера Бена, який йде вода, розмовляє з собаками і контролює життя».

ChatGPT буквально залучив увесь день, з ранку до вечора, розпорядок дня містера Бена, якого насправді не існує, але підіграв підказку, яку йому подали, що є однією з причин галюцинацій ШІ.

Розмова про те, що занадто щасливий, щоб догодити!

Що ж, які причини, давайте розглянемо ще кілька причин, які викликають галюцинації ШІ.

Чому виникають галюцинації ШІ?

Існує кілька технічних причин і причин галюцинацій ШІ. Ось деякі з можливих причин:

- Низька якість, недостатня кількість або застарілі дані: LLMs та моделі штучного інтелекту значною мірою покладаються на навчальні дані. Отже, вони настільки хороші, наскільки хороші дані, на яких їх навчають. Якщо інструмент штучного інтелекту має помилки, невідповідності, упередження або неефективність у своїх навчальних даних або якщо він просто не розуміє запитувану підказку, це створить галюцинації ШІ, оскільки інструмент генерує вихідні дані з обмеженого набору даних.

- Переобладнання: навчаючись на обмеженому наборі даних, модель штучного інтелекту може намагатися запам’ятати підказки та відповідні результати, що робить її нездатною ефективно генерувати або узагальнювати нові дані, що призводить до галюцинацій ШІ.

- Контекст введення: галюцинації штучного інтелекту також можуть виникати через нечіткі, неточні, непослідовні або суперечливі підказки. Хоча набір навчальних даних моделі штучного інтелекту не в руках користувачів, вхідні дані, які вони вводять як підказку, є. Тому дуже важливо надавати чіткі підказки, щоб уникнути галюцинацій ШІ.

- Використання ідіом або сленгових виразів: якщо підказка складається з ідіом або сленгу, існує висока ймовірність галюцинацій штучного інтелекту, особливо якщо модель не навчена використовувати такі слова чи сленгові вирази.

- Змагальні атаки: іноді зловмисники навмисно вводять підказки, призначені для того, щоб заплутати моделі штучного інтелекту, пошкоджуючи їхні навчальні дані та викликаючи галюцинації штучного інтелекту.

Негативні наслідки галюцинацій ШІ

Галюцинації штучного інтелекту є серйозною етичною проблемою зі значними наслідками для окремих людей і організацій. Ось різні причини, через які галюцинації штучного інтелекту стають серйозною проблемою:

- Поширення дезінформації: галюцинації штучного інтелекту через неправильні підказки або невідповідності в навчальних даних можуть призвести до масового поширення дезінформації, що впливає на широке коло осіб, організацій і державних установ.

- Недовіра серед користувачів: коли дезінформація, створена штучним інтелектом, блискавично поширюється в Інтернеті, роблячи її схожою на авторитетну та написану людьми, це підриває довіру користувачів, ускладнюючи довіру інформації в Інтернеті.

- Шкода користувача: окрім етичних проблем і введення людей в оману, галюцинації штучного інтелекту також можуть потенційно завдати шкоди людям, поширюючи дезінформацію про деякі серйозні проблеми та теми, як-от хвороби, їх лікування або прості поради, як відрізнити смертельно отруйні їстівні гриби від здорових. Навіть незначна дезінформація чи неточність можуть загрожувати життю людини.

Найкращі методи виявлення та запобігання галюцинаціям ШІ

Дивлячись на наведені вище негативні наслідки галюцинацій штучного інтелекту, запобігання їм має вирішальне значення будь-якою ціною. Хоча компанії, які володіють цими моделями штучного інтелекту, наполегливо працюють над усуненням або зменшенням галюцинацій штучного інтелекту, ми вживаємо всіх можливих заходів, оскільки користувачі мають велике значення.

На основі невеликих досліджень, свого досвіду та методів проб і помилок я запропонував кілька стратегій виявлення та запобігання галюцинаціям штучного інтелекту під час наступного використання чат-бота або взаємодії з великою мовною моделлю (LLM).

#1. Використовуйте репрезентативні та різноманітні навчальні дані

Як користувачу, дуже важливо використовувати LLM з різноманітним набором навчальних даних, який представляє реальний світ, зменшуючи ймовірність того, що результат буде упередженим, неточним або вигаданим.

Водночас власники компаній повинні регулярно оновлювати та розширювати набори навчальних даних моделі штучного інтелекту, щоб враховувати культурні, політичні та інші події, що розвиваються, і отримувати інформацію про них.

#2. Обмежте результати або відповіді

Як користувач, ви можете обмежити кількість потенційних відповідей, які може генерувати інструмент ШІ, надавши йому конкретну підказку щодо типу відповіді, яку ви хочете.

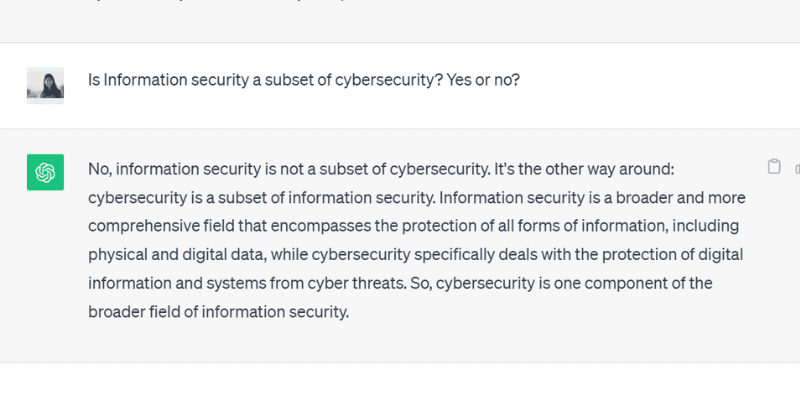

Наприклад, ви можете спеціально запитати підказку та наказати моделі відповідати лише так чи ні. Або ви також можете надати кілька варіантів у підказці інструменту на вибір, обмежуючи його можливість відхилятися від фактичної відповіді та галюцинувати.

Коли я поставив ChatGPT GPT 3.5 запитання з відповідями «так» або «ні», він точно згенерував такий результат:

#3. Упакуйте та заземліть модель відповідними даними

Ви не можете очікувати, що людина запропонує вирішення будь-якої конкретної проблеми чи запитання без попередніх знань або надання конкретного контексту. Подібним чином, модель штучного інтелекту настільки хороша, наскільки хороший набір навчальних даних, який ви вводите в неї.

Обґрунтування або упаковка навчальних даних моделі штучного інтелекту відповідними галузевими даними та інформацією надає моделі додатковий контекст і точки даних. Цей додатковий контекст допомагає моделі штучного інтелекту покращити своє розуміння, дозволяючи їй генерувати точні, розумні та контекстуальні відповіді замість галюцинованих відповідей.

#4. Створіть шаблони даних для моделі ШІ

Надання шаблону даних або прикладу конкретної формули чи розрахунку в попередньо визначеному форматі може значно допомогти моделі ШІ генерувати точні відповіді відповідно до встановлених інструкцій.

Застосування вказівок і шаблонів даних зменшує ймовірність галюцинації моделями ШІ та забезпечує послідовність і точність згенерованих відповідей. Таким чином, надання еталонної моделі у форматі таблиці або прикладу може фактично керувати моделлю штучного інтелекту в обчисленні, усуваючи випадки галюцинацій.

#5. Будьте дуже конкретними у своєму запиті, призначивши моделі певну роль

Призначення конкретних ролей моделі штучного інтелекту є одним із найяскравіших і ефективних способів запобігти галюцинаціям. Наприклад, ви можете надати підказки на зразок «Ви досвідчений і вмілий гітарист» або «Ви блискучий математик», а потім ваше конкретне запитання.

Призначення ролей спрямовує модель надавати потрібну відповідь замість вигаданих галюцинованих відповідей.

І не переживай. Ви все ще можете розважатися зі ШІ (не зважаючи на галюцинації). Подивіться, як самостійно створити вірусну спіраль ШІ!

#6. Перевірте температурою

Температура відіграє вирішальну роль у визначенні ступеня галюцинацій або творчих реакцій, які може генерувати модель ШІ.

У той час як нижча температура зазвичай означає детерміновані або передбачувані результати, вища температура означає, що модель штучного інтелекту, швидше за все, генеруватиме випадкові реакції та галюцинації.

Кілька компаній штучного інтелекту надають панель «Температура» або повзунок зі своїми інструментами, щоб користувачі могли регулювати параметри температури відповідно до своїх уподобань.

У той же час компанії також можуть встановити температуру за замовчуванням, дозволяючи інструменту генерувати розумні відповіді та встановлювати правильний баланс між точністю та креативністю.

#7. Завжди перевіряйте

Нарешті, покладатися на 100% результату, створеного штучним інтелектом, без подвійної перевірки чи фактів — нерозумний крок.

Хоча компанії та дослідники штучного інтелекту вирішують проблему галюцинацій і розробляють моделі, які запобігають цій проблемі, користувачеві дуже важливо перевірити відповіді, які генерує модель штучного інтелекту, перш ніж використовувати або повністю повірити в неї.

Таким чином, поряд із використанням вищезазначених найкращих практик, від написання підказки зі специфікаціями до додавання прикладів у підказку для керівництва ШІ, ви завжди повинні перевіряти та перехресно перевіряти результати, які створює модель ШІ.

Чи можете ви повністю виправити або видалити галюцинації ШІ? Погляд експерта

У той час як керування галюцинаціями штучного інтелекту залежить від підказки, яку ми їй надаємо, іноді модель генерує вихідні дані з такою впевненістю, що важко розрізнити, що є фальшивкою, а що правдою.

Отже, зрештою, чи можливо повністю виправити або запобігти галюцинаціям ШІ?

Коли поставили це питанняСуреш Венкатасубраманян, професор Університету Брауна, відповів, що те, чи можна запобігти галюцинаціям штучного інтелекту чи ні, є «темою активного дослідження».

Причина цього, далі він пояснив, полягає в природі цих моделей штучного інтелекту — наскільки вони складні, заплутані та крихкі. Навіть невелика зміна швидкого введення може суттєво змінити результати.

У той час як Венкатасубраманіан вважає вирішення проблеми галюцинацій ШІ предметом дослідження, Джевін Вест, професор Вашингтонського університету та співзасновник Центру інформованої громадськості, вважає, що галюцинації ШІ ніколи не зникнуть.

Вест вважає, що неможливо сконструювати галюцинації, які виникають від ШІ-ботів або чат-ботів. І, отже, галюцинації штучного інтелекту завжди можуть бути присутніми як внутрішня характеристика штучного інтелекту.

Крім того, заявив Сундар Пічаї, генеральний директор Google інтерв’ю CBS що кожен, хто використовує штучний інтелект, стикається з галюцинаціями, але ніхто в галузі ще не вирішив проблему галюцинацій. З цією проблемою стикаються майже всі моделі AI. Крім того, він заявив і запевнив, що галюцинації штучного інтелекту незабаром прогресуватимуть.

У той же час Сем Альтман, генеральний директор OpenAI, що створює ChatGPT, відвідав індійський Інститут інформаційних технологій Індрапрастха в Делі в червні 2023 року, де зазначив, що проблема галюцинацій штучного інтелекту постане набагато краще через півтора року, ніж два роки.

Крім того, він додав, що модель вимагатиме вивчення різниці між точністю та креативністю та того, коли використовувати те чи інше.

Підведенню

В останні роки галюцинації штучного інтелекту привернули чималу увагу, і компанії та дослідники намагаються вирішити та подолати їх якомога раніше.

Хоча штучний інтелект досяг значного прогресу, він не застрахований від помилок, і проблема галюцинацій штучного інтелекту створює серйозні проблеми для кількох людей і галузей, включаючи охорону здоров’я, створення контенту та автомобільну промисловість.

Поки дослідники виконують свою роботу, ми, як користувачі, також зобов’язані надавати конкретні та точні підказки, додавати приклади та надавати шаблони даних, щоб отримати дійсні та розумні відповіді, уникати плутанини з навчальними даними моделі ШІ та запобігати галюцинаціям.

Навіть якщо галюцинації штучного інтелекту можна повністю вилікувати або виправити, все ще залишається питанням; Я особисто вірю, що є надія, і ми можемо продовжувати використовувати системи ШІ, щоб приносити користь світу відповідально та безпечно.

Далі приклади штучного інтелекту (ШІ) у нашому повсякденному житті.