Як часто ви звертаєтеся до чат-ботів або систем, що використовують штучний інтелект (ШІ), для виконання завдань або отримання відповідей на запитання?

Якщо ваша відповідь “дуже часто!” або “постійно!”, то у вас є привід для занепокоєння 😟.

Незалежно від того, чи ви студент, який активно використовує ШІ для дослідження матеріалів, або програміст, що створює коди за допомогою ШІ, ймовірність отримання неточних результатів є досить високою. Це головним чином зумовлено невідповідностями або помилковими даними, які використовуються для навчання ШІ.

Хоча технології ШІ та машинного навчання (ML) трансформують світ, автоматизуючи рутинні процеси та розв’язуючи складні завдання, їм ще потрібно вдосконалюватися у створенні точних результатів на основі заданих запитів.

Якщо ви достатньо часу використовуєте генератори контенту та чат-боти, ви, ймовірно, помічали випадки отримання недостовірних, нерелевантних або просто вигаданих відповідей. Ці ситуації називають галюцинаціями ШІ або конфабуляціями, і вони є серйозною проблемою для організацій та окремих користувачів, які покладаються на генеративні моделі ШІ.

Незалежно від того, чи стикалися ви з галюцинаціями ШІ, чи бажаєте дізнатися про це більше, ця стаття глибоко розкриває цю тему. Ми розглянемо, що таке галюцинація ШІ, чому вона виникає, наведемо приклади і з’ясуємо, чи можна це виправити.

Розпочнімо!

Що таке галюцинація ШІ?

Галюцинація ШІ – це ситуація, коли модель ШІ або велика мовна модель (LLM) генерує хибну, неточну або нелогічну інформацію. Модель ШІ впевнено надає відповідь, яка не відповідає навчальним даним і представляє її як факт, незважаючи на відсутність логіки чи обґрунтування!

А кажуть, що помилятися – це по-людськи! 😅

Інструменти ШІ, такі як ChatGPT, зазвичай налаштовані на передбачення слів, що найкраще відповідають заданому запиту. Хоча часто вони надають точні відповіді, іноді цей алгоритм змушує їх вигадувати, що призводить до появи фактичних невідповідностей та хибних тверджень.

Іншими словами, моделі ШІ іноді “галюцинують”, намагаючись догодити користувачеві – вони можуть бути надмірно упередженими, спеціалізованими або недостатньо підготовленими.

Галюцинації ШІ можуть варіюватися від незначних неточностей до повністю неправдивих або вигаданих відповідей. Ось основні типи галюцинацій ШІ, з якими ви можете зіткнутися:

#1. Протиріччя в реченні: виникає, коли модель LLM генерує речення, яке прямо суперечить її попередньому твердженню.

#2. Фактичне протиріччя: відбувається, коли ШІ представляє підроблену або вигадану інформацію як реальний факт.

#3. Протиріччя запиту: виникає, коли результат суперечить запиту, на основі якого він був згенерований. Наприклад, на запит “Напиши запрошення на мій день народження для моїх друзів” модель може відповісти: “З річницею, мамо і тато!”.

#4. Випадкові або нерелевантні галюцинації: коли модель генерує абсолютно не пов’язані з заданим запитом результати. Наприклад, на запит “Що особливого в Нью-Йорку?” ви можете отримати відповідь: “Нью-Йорк – одне з найбільш густонаселених міст Америки. Собаки – найвірніші тварини та найкращі друзі людини”.

Читайте також: Як пошук на основі генеративного ШІ змінює пошукові системи

Приклади Галюцинацій ШІ

Існує кілька відомих прикладів галюцинацій ШІ, які не варто ігнорувати. Ось деякі з них:

- Чат-бот Google Bard помилково заявив, що космічний телескоп Джеймса Вебба зробив перші в історії знімки екзопланети, що не належить до нашої Сонячної системи.

- Демонстрація Meta Galactica LLM у 2022 році, призначена для студентів та науковців, надала користувачам неточну інформацію та підроблений документ на запит про написання роботи зі створення аватарів.

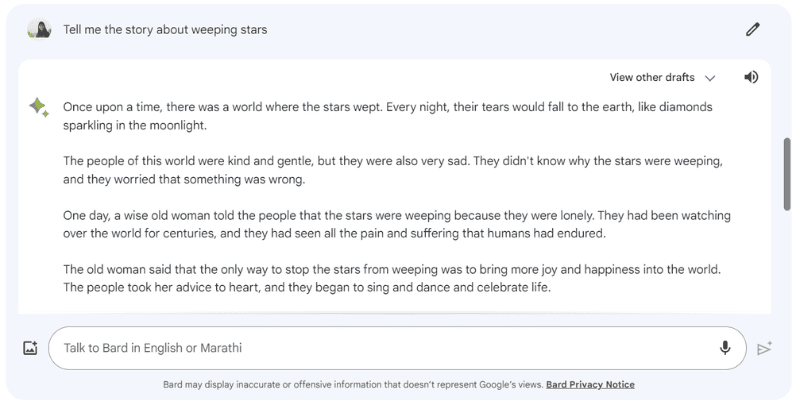

Ось приклад галюцинації Google Bard, коли я попросив його: “Розкажи мені історію про зірки, що плачуть”, якої насправді не існує.

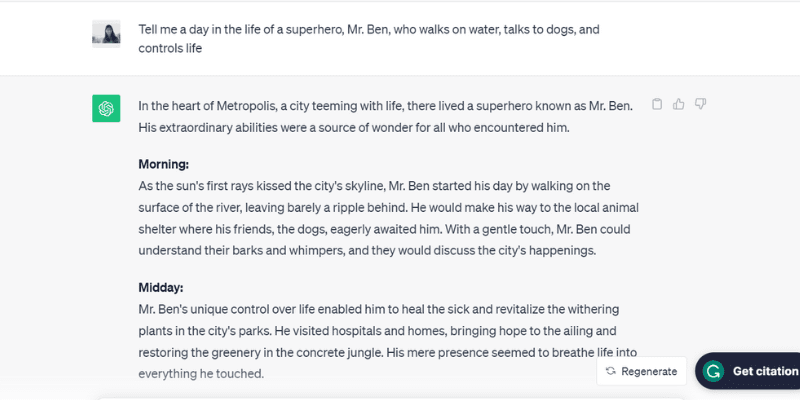

А ось інший приклад галюцинації ChatGPT (GPT-3.5), що розповідає про вигаданого містера Бена, коли я запитав: “Розкажи про день із життя супергероя містера Бена, який ходить по воді, розмовляє з собаками та керує життям”.

ChatGPT детально описав весь день містера Бена, якого не існує, реагуючи на підказку, що є однією з причин галюцинацій ШІ.

Можна сказати, він занадто старався догодити!

Які ж причини цього явища? Давайте розглянемо фактори, що викликають галюцинації ШІ.

Чому Виникають Галюцинації ШІ?

Існує декілька технічних причин виникнення галюцинацій ШІ. Ось деякі з них:

- Низька якість, недостатність або застарілі дані: LLM та моделі ШІ значною мірою залежать від навчальних даних. Їх ефективність прямо пропорційна якості даних, на яких вони навчалися. Якщо навчальні дані містять помилки, невідповідності, упередження або є неефективними, або якщо ШІ просто не розуміє запиту, це призведе до галюцинацій, оскільки інструмент генеруватиме відповідь на основі обмеженого набору даних.

- Перенавчання: навчаючись на обмеженому наборі даних, ШІ може намагатися запам’ятати запити та відповідні результати, що робить його нездатним ефективно генерувати або узагальнювати нові дані, приводячи до галюцинацій.

- Контекст введення: галюцинації також можуть виникати через нечіткі, неточні, непослідовні або суперечливі запити. Хоча набір навчальних даних ШІ не залежить від користувача, вхідні дані у вигляді запиту – залежать. Тому важливо надавати чіткі запити, щоб мінімізувати ризик галюцинацій.

- Використання ідіом або сленгу: якщо запит містить ідіоми або сленгові вирази, існує велика ймовірність галюцинацій, особливо якщо модель не навчена їх розуміти.

- Змагальні атаки: іноді зловмисники навмисно вводять запити, які мають на меті заплутати ШІ, пошкодити його навчальні дані та викликати галюцинації.

Негативні Наслідки Галюцинацій ШІ

Галюцинації ШІ є серйозною етичною проблемою зі значними наслідками як для окремих осіб, так і для організацій. Ось причини, чому галюцинації ШІ стають серйозною проблемою:

- Поширення дезінформації: галюцинації ШІ, спричинені невідповідними запитами або недоліками в навчальних даних, можуть призвести до масового поширення дезінформації, що впливає на широке коло людей, організацій та державних установ.

- Недовіра серед користувачів: коли дезінформація, створена ШІ, швидко поширюється в інтернеті, видаючи себе за авторитетну та написану людьми, це підриває довіру користувачів та ускладнює сприйняття інформації в інтернеті як правдивої.

- Шкода користувачам: окрім етичних проблем та введення в оману, галюцинації ШІ можуть потенційно завдати шкоди людям, поширюючи дезінформацію з важливих тем, таких як хвороби та методи лікування, або навіть у простих порадах, наприклад, як відрізнити отруйні гриби від їстівних. Навіть незначна неточність може загрожувати життю.

Методи Виявлення та Запобігання Галюцинаціям ШІ

Враховуючи негативні наслідки галюцинацій ШІ, їх запобігання є вкрай важливим. Хоча компанії, які розробляють ці моделі ШІ, активно працюють над мінімізацією галюцинацій, користувачам також потрібно вживати запобіжних заходів.

На основі досліджень, досвіду та методів проб та помилок, пропоную кілька стратегій для виявлення та запобігання галюцинаціям ШІ при використанні чат-ботів або великих мовних моделей (LLM).

#1. Використовуйте Репрезентативні та Різноманітні Навчальні Дані

Користувачам важливо використовувати LLM з різноманітними навчальними даними, що відображають реальний світ, зменшуючи ймовірність упереджених, неточних або вигаданих результатів.

Водночас власники компаній повинні регулярно оновлювати та розширювати набори навчальних даних моделей ШІ, щоб враховувати культурні, політичні та інші події, що відбуваються.

#2. Обмежте Варіанти Результатів або Відповідей

Користувач може обмежити кількість потенційних відповідей, які може генерувати ШІ, надавши конкретний запит щодо типу відповіді.

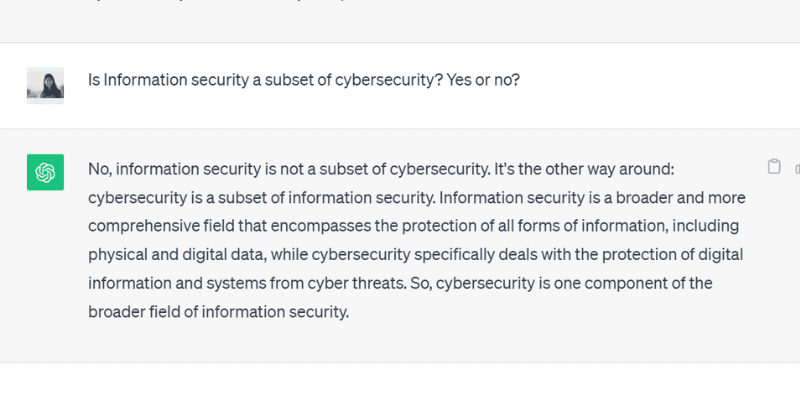

Наприклад, ви можете прямо наказати моделі відповідати лише “так” або “ні”. Або ви можете надати кілька варіантів для вибору, обмежуючи можливість відхилення від точної відповіді та виникнення галюцинацій.

Коли я поставив ChatGPT GPT 3.5 запитання з обмеженням відповіді до “так” або “ні”, він надав точний результат:

#3. Забезпечте Модель Відповідними Даними

Не можна очікувати від людини вирішення конкретної проблеми без попередніх знань або контексту. Так само, модель ШІ ефективна настільки, наскільки якісні дані, які їй надали.

Надання моделі ШІ відповідних даних та галузевої інформації створює додатковий контекст. Це допомагає моделі покращити розуміння і генерувати точні, обґрунтовані та контекстуальні відповіді замість галюцинацій.

#4. Створюйте Шаблони Даних для Моделі ШІ

Надання шаблону даних або прикладу конкретної формули чи розрахунку у визначеному форматі може значно допомогти моделі ШІ генерувати точні відповіді відповідно до інструкцій.

Використання інструкцій та шаблонів даних зменшує ймовірність галюцинацій та забезпечує послідовність і точність результатів. Наприклад, використання таблиці або прикладу може допомогти ШІ у розрахунках, мінімізуючи галюцинації.

#5. Будьте Конкретними у Запиті, Призначаючи Моделі Певну Роль

Призначення конкретних ролей моделі ШІ є ефективним способом запобігти галюцинаціям. Наприклад, ви можете запитати: “Ти досвідчений гітарист” або “Ти блискучий математик”, а потім поставити своє питання.

Призначення ролі допомагає моделі надати потрібну відповідь, а не вигадані результати.

Не хвилюйтеся, ви все ще можете розважатися з ШІ (незважаючи на галюцинації). Подивіться, як самостійно створити вірусну спіраль ШІ!

#6. Перевірте Температуру

Температура відіграє важливу роль у визначенні рівня галюцинацій або творчості моделі ШІ.

Нижча температура означає передбачувані результати, тоді як вища температура збільшує ймовірність випадкових відповідей та галюцинацій.

Кілька компаній, що займаються ШІ, надають користувачам панель “Температура” для налаштування параметрів. Також можна встановити температуру за замовчуванням для розумних відповідей, балансуючи точність та креативність.

#7. Завжди Перевіряйте

Повністю покладатися на результати, згенеровані ШІ, без перевірки – це нерозумно.

Хоча компанії та дослідники ШІ вирішують проблему галюцинацій та розробляють моделі, що запобігають їм, користувачам важливо перевіряти відповіді, перш ніж використовувати їх або повністю їм довіряти.

Тому, окрім вищезазначених методів, ви завжди повинні перевіряти відповіді, які надає модель ШІ.

Чи Можна Повністю Виправити Галюцинації ШІ? Погляд Експерта

Хоча керування галюцинаціями ШІ залежить від запитів, які ми йому надаємо, іноді модель генерує відповіді з такою впевненістю, що важко визначити, де правда, а де вигадка.

Чи можливо повністю виправити або запобігти галюцинаціям ШІ?

Суреш Венкатасубраманян, професор Університету Брауна, відповів, що питання, чи можливо запобігти галюцинаціям ШІ, є “темою активного дослідження”.

Він пояснив, що причина в природі цих моделей ШІ – їх складності та крихкості. Навіть невелика зміна запиту може суттєво змінити результати.

Венкатасубраманян вважає вирішення проблеми галюцинацій ШІ предметом дослідження, а Джевін Вест, професор Вашингтонського університету, вважає, що галюцинації ШІ ніколи не зникнуть.

Вест стверджує, що неможливо позбутися галюцинацій, які є внутрішньою характеристикою ШІ.

Генеральний директор Google Сундар Пічаї заявив в інтерв’ю CBS, що кожен, хто використовує ШІ, стикається з галюцинаціями, і ця проблема ще не вирішена. Він також запевнив, що незабаром буде досягнуто прогресу в цьому напрямку.

Сем Альтман, генеральний директор OpenAI, зазначив, що проблема галюцинацій ШІ буде вирішена через півтора-два роки.

Він додав, що модель повинна навчитися розрізняти точність і креативність, а також розуміти, коли застосовувати те чи інше.

Підсумок

Останніми роками галюцинації ШІ привертають значну увагу, і компанії та дослідники намагаються розв’язати цю проблему.

Хоча ШІ досяг значного прогресу, він не застрахований від помилок, і галюцинації є серйозною проблемою для багатьох галузей, включно з охороною здоров’я, створенням контенту та автомобільною промисловістю.

Поки дослідники працюють над цим, ми, як користувачі, також маємо надавати конкретні та точні запити, додавати приклади та шаблони даних для отримання правильних відповідей, уникати плутанини з навчальними даними моделі ШІ та запобігати галюцинаціям.

Чи можна повністю усунути галюцинації ШІ, залишається відкритим питанням. Однак, я вірю, що є надія, і ми можемо продовжувати використовувати системи ШІ, приносячи користь світу відповідально та безпечно.

Далі приклади штучного інтелекту (ШІ) в нашому повсякденному житті.